App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

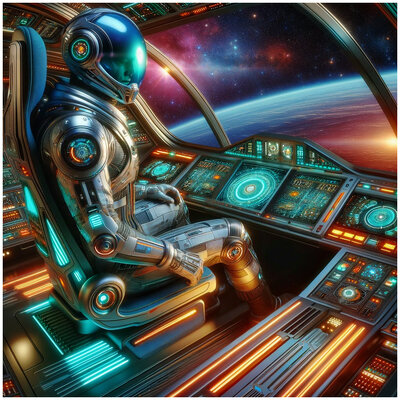

Neueste KI zur Bilderzeugung

- Ersteller Lois

- Erstellt am

Area88

||||||||||||

Wegen des Querformats: womit gemacht?

VEB Synthesewerk

Thomas B. aus SAW

Wegen des Querformats: womit gemacht?

ChatGPT —>image generator

Golden-Moon

Ambient...to the sky and back

Ist mir bis jetzt noch nicht untergekommen.Gibt es inzwischen KI-generierte Bilder, auf denen Tastaturen korrekt dargestellt werden?

Bei mir variiert das glaube ich auch. Hatte es öfter am Nachmittag / Abend beobachtet.Bezüglich der täglichen 15 Boostpunkte beim B.I.C. ein Frage in die Runde:

Kommen die Punkte bei Euch auch grundsätzlich zu nicht vorhersehbaren Zeitpunkten? Bei mir manchmal um gegen 9:00 a.m. manchmal erst 11:00 a.m. ...

Was macht ihr eigentlich mit euren Reward-Punkten? Bin bei knapp 2000.

Für Boosts finde ich sie zu schade. Weiter sparen für Amazon Gutschein?

vogel

Lebensform, fortgeschritten

Golden-Moon

Ambient...to the sky and back

Ich hab euch gewarnt

RealRider

\___‹[(Ö)]›___/

ich habe gestern gar keine bekommenBezüglich der täglichen 15 Boostpunkte beim B.I.C. ein Frage in die Runde:

Kommen die Punkte bei Euch auch grundsätzlich zu nicht vorhersehbaren Zeitpunkten? Bei mir manchmal um gegen 9:00 a.m. manchmal erst 11:00 a.m. ...

vielleicht ne Strafe für mehrfachen Content-Verstoss

die sind so elend pingelig... einfache Worte werden im Kontext nicht verstanden ...ein richtiger Robo Cop

dann weisst du nicht unbedingt welches Wort den Verstoss ausgelöst hat und rennst 3x hintereinander in die Falle

Gastank ( im Sinne von Gasoline) bzw. Tank geht nicht...weil es wohl als Panzer interpretiert wird

es ist halt f.....g Microsoft

eine Menschengestalt mit einem "Skull Face" oder einem "Brain Head" macht er auch nicht

dann wirst du bestraft, weil das Ding doof ist.... ich freue mich auf die Zukunft

ollo

||||||||||||

eine Menschengestalt mit einem "Skull Face" oder einem "Brain Head" macht er auch nicht

dann wirst du bestraft, weil das Ding doof ist.... ich freue mich auf die Zukunft

Hmm, also als ich damit rumgespielt habe ging das, Brutalität war fast nie Thema, vielleicht haben die das mittlerweile angepasst. Ich war selbst immer erstaunt, was die KI teilweise für blutige Bilder ausgespuckt hat. Gesperrt wurde ich nie.

Soljanka

|||||||||||||

Ich hab euch gewarnt

Bei mir kam die Contentwarnug schon öfter wahllos. Bei Prompts, die keinerlei anzügliches hatten und ansonsten auch problemlos funktionierten.

Wenn der also Bilder kreiert, die Probleme verursachen (ohne, dass ich das wollte) ist das sein Problem. Denke ich mir dann.

Dennoch – was, wenn das Überhand nimmt ohne, dass ich da Schuld habe?

Golden-Moon

Ambient...to the sky and back

Wenn du ne nackte Frau sehen willst ist das nicht ok. Wenn er will das du eine siehst ist das okWenn der also Bilder kreiert, die Probleme verursachen (ohne, dass ich das wollte) ist das sein Problem. Denke ich mir dann.

Soljanka

|||||||||||||

Wenn er will das du eine siehst ist das ok

Das wäre mir ja Wurscht. Aber er soll dann halt nicht rum jammern und mir die Schuld in die Schuhe schieben.

elabtronx

||||||||||

Da ist mir noch keine bestimmte Uhrzeit aufgefallen.Bezüglich der täglichen 15 Boostpunkte beim B.I.C. ein Frage in die Runde:

Kommen die Punkte bei Euch auch grundsätzlich zu nicht vorhersehbaren Zeitpunkten? Bei mir manchmal um gegen 9:00 a.m. manchmal erst 11:00 a.m. ...

Habe ehrlich gesagt auch noch nicht drauf geachtet.

Wenn ich aber zb noch 6 übrig hatte, den Browser bzw das Tab offen lasse und am nächsten Tag was neues versuche, wird die Seite neu geladen, das eingegebene promt ist weg (selig wer es je nach länge vorher speicherte) und es stehen wieder 15 neue bereit (vermute mal man kann mit 24 Std seit dem letzten einloggen rechnen?).

Wenn die neuen Punkte verbraucht sind und ich aber noch weitere Ideen habe, lasse ich das Ding im Hintergrund weiter rattern, oder wie weiter oben schonmal erwähnt, breche ich den Vorgang einfach ab und lasse mir anzeigen was bis dahin fabriziert wurde. (edit: was ich damit sagen wollte; deshalb habe ich noch nie genau drauf geachtet)

Apropos Beispiel oben - Schade dass die unverbrauchten Boosts nicht genauso gesammelt werden können wie die Reward Punkte.

Bin aktuell bei ca 3500. Für Boosts habe ich aber auch noch keine verwendet. Und auch nicht für irgendwas anderes.Was macht ihr eigentlich mit euren Reward-Punkten? Bin bei knapp 2000.

Für Boosts finde ich sie zu schade. Weiter sparen für Amazon Gutschein?

Hatte das zwecks anderweitge Verwendung aber bisher auch noch gar nicht richtig auf dem Schirm.

Schaue ich mir mal an, Danke.

Klicke mich bei Langeweile (bzw wenn es mal wieder länger dauert) ab und zu durch die Rätsel dort.

Wo es ja egal ist ob man irgendwas richtig anklickt. Die Punkte bekommt man trotzdem. :]

Man kann ja nie wissen für was mal es gut ist und man dann doch "dringend Boosts braucht.. (zb für last minute Compilation Cover ; )

finde ich auchdie sind so elend pingelig

ollo

||||||||||||

Habe das Programm grade nochmal kurz angeworfen, Training in 512x512 für SD 1.5 braucht rund 31%, sollte also auf 10-12GB VRAM funktionieren. Die Zeitdauer in der kleinen Auflösung ist knapp unter einer Stunde. Ich lasse das mal jetzt durchlaufen.

Das SDXL Training hat wie oben geschrieben etwas über 3.5h gedauert, also tatsächlich etwa 4x solange für die 4fache Auflösung.

Auslastung und Zeitdauer:

Anhang anzeigen 201670

Anhang anzeigen 201669

Mehr SDXL Bilder:

Anhang anzeigen 201671Anhang anzeigen 201672Anhang anzeigen 201673Anhang anzeigen 201674

Was mich ja jetzt mal interessieren würde, was passiert, wenn man ein Modell absichtlich falsch trainiert. Also zB eines, damit absichtlich total falsche Körperformen entstehen. Und was passiert, wenn man ein Base-Modell einfach nur mit einem Foto trainiert, entsteht dann digitale Glitch-Art oder wie kann man sich das vorstellen?

Golden-Moon

Ambient...to the sky and back

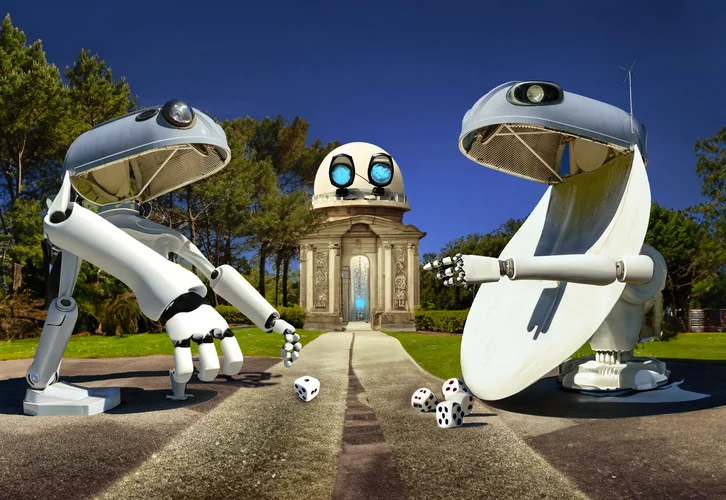

Thomasch

MIDIChorianer

Was war denn hier der Prompt?

Rudolph the Braindeer?

Golden-Moon

Ambient...to the sky and back

Was war denn hier der Prompt?

Rudolph the Braindeer?

Der Prompt beinhaltete "funny christmas elk with Brainstruck talking to beautiful woman"

ollo

||||||||||||

(Anmerkung: Würde man den Bing Generator abbrechen können wie manche vermuten, würde das genau so unscharf aussehen je nachdem wie weit er schon gerechnet hat.)

Ja, bei Stable Diffusion sehe ich ja auch in der Vorschau einmal ein sehr unscharfes Bild, was einen aber schonmal erkennen lässt, ob das in die richtige Richtung geht.

Das Ink Training (Bilder im vorletzten Post) oder das Sparkify Training (letzter Post) ist vom Basismodell komplett losgelöst und wird per Huckepack auf ein bestehendes Modell aufgesetzt (nennt sich LoRa). Der Dateninhalt basiert damit zu 100% auf eigenen Bildern.

LoRas habe ich bisher nur einmal ausprobiert zum Testen, die LoRa aus dem Netz hätte dann aus jedem Bild irgendso ein Anime-Mädchen eines mir nicht bekannten Animes gemacht, aber irgendwie hatte das gar keinen Einfluss auf das Endergebniss. Muss ich mir alles nochmal genauer anschauen.

Hätte ich 60k €, würde ich mir 2 fette Nvidia Karten kaufen und die Nummer von Grund auf selber anlegen, aber eine RTX4090 ist nur Spielzeug in dem Bereich. Für 100000 Bilder müsste ich den Pc einen ganzen Monat rechnen lassen. Die bestehenden Basismodelle wurden mit bis zu 5600000000 aus dem LAION Datensatz trainiert.

Und am Besten dann noch einen ordentlichen Solarpark dazu, damit man das guten Gewissens durchrattern lassen kann.

Man könnte natürlich auch einen Server mieten aber man will ja nicht die eigenen Fotos auslagern, wer weiß wo die landen.

Alleine deswegen ist Stable Diffusion lokal schon so interessant für mich, weil man eigene Fotos damit verwursten kann ohne das irgendjemand das Ursprungsfoto bekommt.

Zuletzt bearbeitet:

verstaerker

*****

Golden-Moon

Ambient...to the sky and back

aljen

||||

electric guillaume

keine Information

Wie hast du es hinbekommen, dass die Tastaturen richtig aussehen?Weil es so schön war, da oben.

Wegen des Wintereinbruchs wurde allerdings der Weiterflug zum Mars gecancelt.

Ehrlich gesagt war ich ein wenig enttäuscht. Aber was soll's. Solange das Instrumentarium stimmt…

Viele Grüße, aljenAnhang anzeigen 202086

aljen

||||

Ich hab sie ganz einfach in meinem Heimstudio fotografiert.Wie hast du es hinbekommen, dass die Tastaturen richtig aussehen?

Das Bild, wie auch die nachfolgenden von mir, ist eine Mischung aus eihenen Fotos (z.T. mehreren) und Adobe Firefly. Firefly ist ja mittlerweile ein Photoshop integriert.

Zuletzt bearbeitet:

Archivicious

|||||||

Das fiel mir auch als erstes auf. Hatte bisher noch nie eine korrekte KI Tastatur gesehen…Wie hast du es hinbekommen, dass die Tastaturen richtig aussehen?

Edit: ok, geschummelt, sehe schon….

aljen

||||

Was heißt hier geschummelt, wer hat hier geschummelt, und überhaupt frag mal einen noch analog/SW gelernten Fotografen und später Grafiker, was "Schummeln" heißt.Das fiel mir auch als erstes auf. Hatte bisher noch nie eine korrekte KI Tastatur gesehen…

Edit: ok, geschummelt, sehe schon….

Similar threads

- Antworten

- 1K

- Aufrufe

- 169K

- Frage

- Antworten

- 218

- Aufrufe

- 12K

- Antworten

- 7

- Aufrufe

- 1K

- Antworten

- 90

- Aufrufe

- 8K

T

- Antworten

- 97

- Aufrufe

- 7K

T

Neueste Beiträge

-

-

-

-

-

-

Beat only Competition Abstimmung + Diskussion Folge Competion / Gemeinschaft

- Letzter: electric guillaume

News

-

2025-04-12 Lille, Kompromat + Ippon - Bilder aus laufender Tour

- Gestartet von Moogulator

- Antworten: 3

-

News 11+14.4.2025 SequencerTalk 238 Live vom Synthfest Frankreich & Modular Speicherbar - live 20:30 jeweils - Ab DANN Montags regulär

- Gestartet von Moogulator

- Antworten: 2

-

-

Tubbutec Programmer für Synthesizer Zusatzfunktionen - MonoPoly, MC202, Juno 60 etc

- Gestartet von Moogulator

- Antworten: 7

-

News SequencerTalk 237 - Drei-Vier-Synclavier - Rückkehr mit anderem Preis, Granular Module und Radio - live 20:30

- Gestartet von Moogulator

- Antworten: 1

-

News Synclavier Keyboard kommt zurück als Ork II (mit Regen als Basis)

- Gestartet von Moogulator

- Antworten: 0

-

Frequency Central Florian - die Synth Stimme Roland-Style

- Gestartet von Moogulator

- Antworten: 11