Golden-Moon

Ambient...to the sky and back

Das nennt sich AI Hallicunation.Ich kann mich da nur fragen: wofür steht das I in KI? Ignoranz?

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Das nennt sich AI Hallicunation.Ich kann mich da nur fragen: wofür steht das I in KI? Ignoranz?

Also das beste was ich dahingehend hinbekomme ist:A, Cool. Ja, so die Richtung.

Hatte das mal mit sehr anfängerhaften Versuchen in D@ll-E versucht. Das ging auch nur so halb. Gesichter und Embleme waren nicht so wirklich erkennbar.

Ab nem gewissen Detailgrad mochte er/sie dann auch nicht mehr.

Möchte damit ein paar Leute ärgern. So was wie H@rry K@ne im Trikot von 186O.

Was macht B.I.C. in diesem Fall?Ich habe mal bei Stable Diffusion "pole dance woman" oder "pole dancing woman" ausprobiert, das führt ohne detailierteren prompt zu sehr lustigen Ergebnissen:

Anhang anzeigen 201534Anhang anzeigen 201535

Die VRAM Auslastung lag bei 23GB, also ganz knapp an den 24GB meiner Karte.

SD 1.5 braucht da weniger Speicher, man kann dort auch mit 512x512 trainieren, allerdings habe ich das verworfen.

Was macht B.I.C. in diesem Fall?

Nix. Der Wortfilter greift und es kommt ein Prompt, dass das Bild nicht generiert werden kann.Was macht B.I.C. in diesem Fall?

OT: wäre mal interessant, wie die forist:innen sich den soundtrack dazu vorstellen ...ein Exemplar in seinem natürlichen Habitat

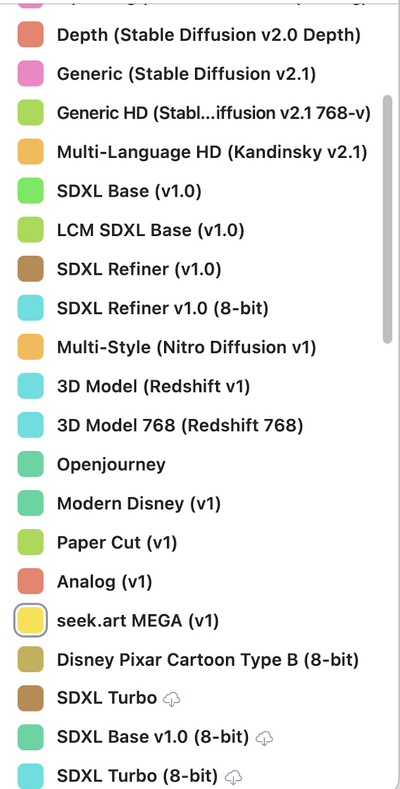

Gibt's hier eigentlich auch jemanden, der mit der Software Draw Things arbeitet?

Das Charmante ist, dass man die unterschiedlichen Modelle runterladen und alles offline generieren kann, ebenfalls die Modifikation vorhandener Bilder.

Habs mir kürzlich geladen, aber noch nicht viel gemacht.

Später dazu mehr

Benjamin Blümchen "Törööö!"wie die forist:innen sich den soundtrack dazu vorstellen

Das scheint ja auch Stable Diffusion zu nutzen, das Ganze aber innehalb einer etwas einfacheren/simpleren Benutzeroberfläche.

Allerdings wohl nur mit Apple, interessieren würde mich, wie lange das auf einem iPhone/iPad dann dauert und ob das obwohl es lokal läuft trotzdem Apple-typisch zensiert ist.

Anhang anzeigen 201684

Und was deine Apple-Zensur-Vermutung betrifft: Nope. Wie denn auch. Musst ja nicht alles in Photos und in der Cloud speichern....

Dann müsste Photoshop auch gesperrt werden, weil da kann man ja auch Nakctbilder mit bearbeitenHätte aber gut sein können, weil Apple alleine ja schon oft genug Apps gesperrt hat, die auch nur im entferntesten etwas mit Sex/Nacktheit zu tun hatten wie damals die App vom Stern oder Focus, weil da eine nackte Person in einem Artikel war. Daher hätte ich mir durchaus vorstellen können, dass der Entwickler lieber auf Nummer sicher gegangen ist und da eine Blacklist eingebaut hätte.

Auch wenn ich Zigaretten abgrundtief hasse...die Bilder sind geil