M

m.a.r.c.u.s

..

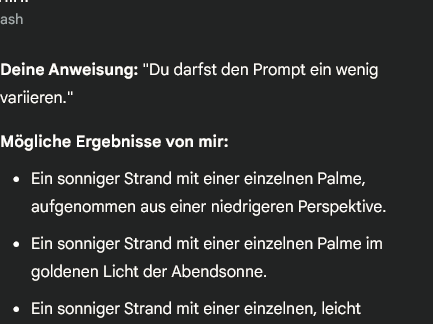

Arbeitet eine der KI so, dass ein Referenzpunkt gesetzt werden kann? DALL-E z.B. fängt ja quasi immer neu an.

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Wenn ich dich jetzt nicht falsch verstanden habe, dann geht das doch mit Chat GPT?! Zumindest auf dem Papier - tatsächlich ist der Dialog recht oberflächlich...*nur mit prompts weiter gehen wäre toll und ist sicherlich grundsätzlich möglich, habe ich aber noch nicht gesehen.

Arbeitet eine der KI so, dass ein Referenzpunkt gesetzt werden kann? DALL-E z.B. fängt ja quasi immer neu an.