Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

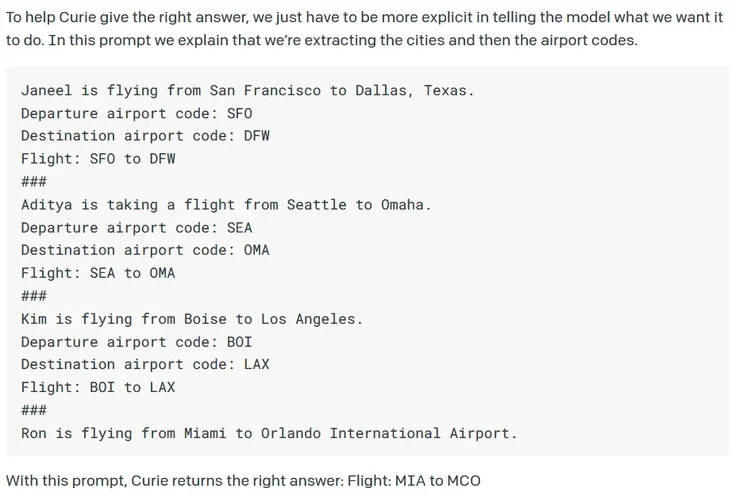

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Neueste KI zur Bilderzeugung

- Ersteller Lois

- Erstellt am

Area88

||||||||||||

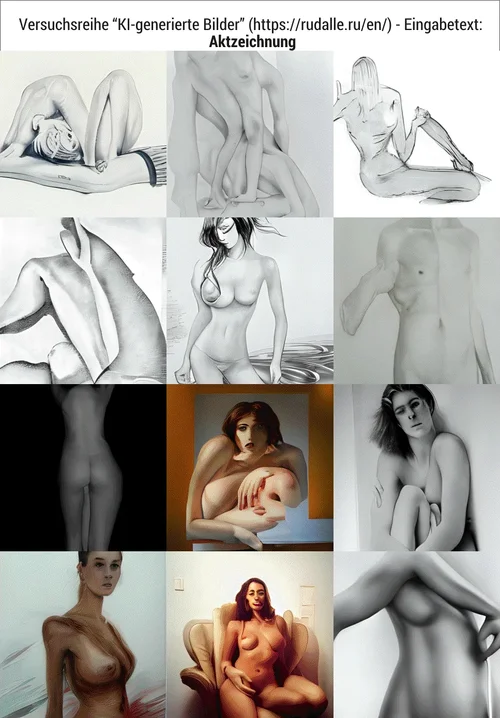

Bagger -gelb

Ich glaube, dass der Ausschluss der Farbe "gelb" ja eine Analyse durch die KI voraussetzt, die entweder nicht stattfindet oder keine Kopplung an die logischen Operatoren (+, -, &, |=oder) erfährt. Ich werde als nächstes versuchen herauszufinden, ob man irgendwie den Zugriff auf Text-beinhaltende Seiten unterbinden kann. Wenn die KI nämlich an den Orten, wo sie meistens Bilder abgreift, nichts passendes findet, scheint sie die Suche auf irgendwelche "Informationsseiten" mit Lexikon-Charakter auszuweiten. Als Kandidat fällt mir da als erstes Wikipedia ein. Mir ist das aufgefallen bei der Eingabe chemischer INN-Bezeichnungen wie "Hexamethylentetramin":

Das sieht mir doch Arsch™ nach Wikipedia aus.

Ergo lautet meine nächste Versuchsreihe: Hexamethylentetramin -Wikipedia

Ich bin dann mal kurz wech...

Area88

||||||||||||

Gleiches Phänomen wie bei meiner vorangegangenen Antwort. Der Ausschluss von Bildinhalten oder -Eigenschaften durch das Minuszeichen würde eine Analyse durch die KI voraussetzen. Erst dann könnte die KI entscheiden, ob sie die ausgeschlossenen Begriffe als Deselektionskriterium verwenden kann/soll. Es gilt vielmehr, auf der Suchebene den Hebel anzusetzen, d.h. die Richtung/Orte wo die KI ihr Ausgangsmaterial bezieht, durch geschickten Einsatz logischer Operatoren zu lenken.hm.

scirocco -volkswagen

Anhang anzeigen 120078 Anhang anzeigen 120079 Anhang anzeigen 120082 Anhang anzeigen 120083

"scirocco" ist zu selten. das sieht ohne "volkswagen", egal ob mit oder ohne "-", genauso aus.

"taunus" ist hingegen zu häufig. das wird ohne "ford" eh immer landschaft.

man bräucht etwas, was es mit und ohne den zusatz etwa gleich häufig geben könnte und zusammen eine anderen kontext hat wie alleine.

oder mal ganz dumm: :)

Wald -Bäume -Baum

Anhang anzeigen 120087 Anhang anzeigen 120088 Anhang anzeigen 120089

sind noch da.

Area88

||||||||||||

Die Frage können wir erst dann beantworten, wenn wir die mit dem iStock-Stempel versauten Bilder nicht sofort verwerfen, sondern mit korrekter Benennung archivieren. Von der Größe dieses Archivs hängt dann die Aussagekraft ab, mit der man Deine Frage beantworten könnte. Ich hab' (leider) auch anfangs diese Bilder immer verworfen ohne mir zu merken oder gar zu notieren, bei welchen Suchbegriffen sie generiert wurden.wo tritt istock content besonders häufig auf?

schnuffke2

||||||||||

schnuffke2

||||||||||

Area88

||||||||||||

schnuffke2

||||||||||

laux

_laux

Was soll denn spannendes angezeigt werden bei "Hexamethylentetramin"? Lt. Bildersuche kommt es doch mit dem von die vorgestellten Bild hin. Eben paar kryptische Zeichen und etwas kyrillischer Text. Meine Vermutung gesucht wird mit Yandex o.ä. Seiten:

schnuffke2

||||||||||

Area88

||||||||||||

Mir ging es darum, die Grenzen der KI auszuloten. Z.B. hätte sie den Begriff ja vielleicht künstlerisch umsetzen können, statt die gefundenen Abbildungen nur zu vektorisieren und an den Stützpunkten herumzumanipulieren. Die Ergebnisse sehen in solchen Fällen (wenn Texte oder Formeln im Spiel sind) nämlich immer danach aus, als hätte man ein Vektorisierungsprogramm falsch bedient...Was soll denn spannendes angezeigt werden bei "Hexamethylentetramin"?

laux

_laux

ollo

||||||||||||

schnuffke2

||||||||||

einseinsnull

[nur noch PN]

Ich werde als nächstes versuchen herauszufinden, ob man irgendwie den Zugriff auf Text-beinhaltende Seiten unterbinden kann. Wenn die KI nämlich an den Orten, wo sie meistens Bilder abgreift, nichts passendes findet, scheint sie die Suche auf irgendwelche "Informationsseiten" mit Lexikon-Charakter auszuweiten.

du solltest wohl nicht davon ausgehen, dass das mit eine live google suche funktioniert, damit wurde das ding nur ursprünglich gefüttert und trainiert.

das erzeugen von bildern funktioniert, indem er "weiß", was "auto" ist, und uns dann eines erfindet. datenbank hat er dafür seine eigene, aber nicht mit bildern, sondern mit meta kram. du merkst ja z.b., dass er in der lage dazu ist, bei gegenständen, die es nirgends so auf fotos gibt, den passenden schatten dazu zu rendern.

wenn du unsern schatzi nach auto gelb fragst, bekommst du auto und gelb.

dass auto und gelb dann zu 80% zu einem gelben auto führen, liegt sicherlich nur am training, nicht an den ausgangsbildern. dort wird eine solche zuordnung noch gar nicht vorgenommen.

ihm wurde nur z.b. beigebracht, dass wenn die bilddatei "gelb" im namen hat, oder auf der gleichen html seite direkt dahinter oder davon "gelb" steht, dass dann ein auto eben so aussieht. dazu muss er nicht mal verstehen, dass gelb eine farbe ist.

technisch dürften das fast alles shader sein (und texturen natürlich - die monalisa als sonderfall liegt also tatsächlich als eine art von "bild"vor - das gelbe auto aber aus einer beschreibung verschiedener möglichkeiten, welche 2D und 3D objekte wie zusammengesetzt sein können, und wie sich farbe und licht darauf verteilen. was ist auto. was ist gelb.)

zusätzlich dürfte es rudimentäre formen von kombinatorik geben, die ich nicht wirklich durchschaue, weil deren wirkung ja vom gefütterten material abhängt (du erinnerst dich an mein mumienproblem)

formen von KI, wie wir sie in musiksoftware oder sprachgeschichten finden, werden dann noch durch "user feedback" weiter trainiert, z.b. um darauf hinzuwirken, dass künftig häufiger die erwartungen des users erfüllt werden.

unser dalli macht das interessanterweise gar nicht. der meint wohl, er weiß schon alles.

auto blau

auto ultraviolett

auto weich

auto böse

auto nackt

auto grmblfx

dass bei kollegen dalli keine bilddateien verwendet werden siehst du ganz prima an den ergebnissen mit "schrift".

er produziert da überwiegend eine art druchschnittsschrift aus lateinisch, kyrillisch und bali, ohne zu verstehen, was "A" ist und wie das so genau aussieht.

außer etwas kommt extrem häufig vor, wie bei dem "iStock" - das kann man meistens ganz gut lesen.

einseinsnull

[nur noch PN]

sowas wie "eiffelturm im regenwald" kann er - scheinbar - semantisch deuten.

ich bin mir aber nicht sicher, ob man ihm das bewusst gezeigt hat, ob er sich das aus anderen bildunterschriften ganz anderer bilder selbst erabeitet hat ("a in b" = "a ist kleiner und irgendwo in der mitte" ??) und mir fällt auch so spontan kein test dafür ein. :)

den unterschied zwischen a b c und a, b, c habe ich auch noch nicht geschnallt.

ich bin mir aber nicht sicher, ob man ihm das bewusst gezeigt hat, ob er sich das aus anderen bildunterschriften ganz anderer bilder selbst erabeitet hat ("a in b" = "a ist kleiner und irgendwo in der mitte" ??) und mir fällt auch so spontan kein test dafür ein. :)

den unterschied zwischen a b c und a, b, c habe ich auch noch nicht geschnallt.

Badda

||||

einseinsnull

[nur noch PN]

ollo

||||||||||||

Anhang anzeigen 120129

london tokio werneuchen

Da hat er wohl den Tokio Tower als Vorbild gehabt.

schnuffke2

||||||||||

ollo

||||||||||||

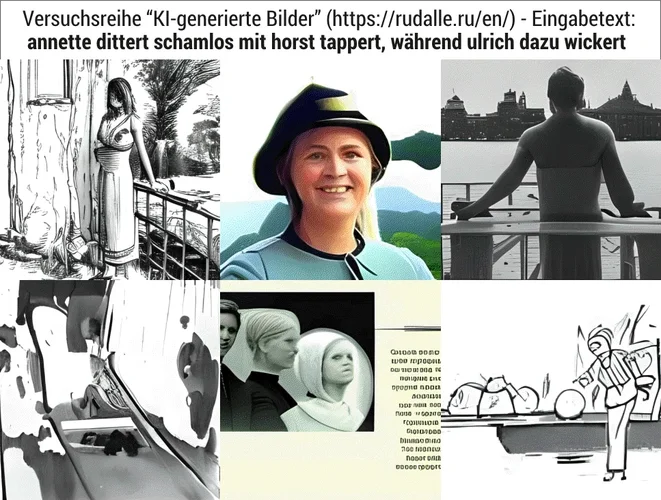

den unterschied zwischen a b c und a, b, c habe ich auch noch nicht geschnallt.

Ich denke mal, das trennt einfach die Suchwörter voneinander. Wenn er King Kong nehmen soll, könnte er nach den beiden einzelnen Wörtern gucken, also auch Bilder mit einem König als Vorlage nehmen, wenn King Kong aber mit einem Komma vom Rest getrennt ist, weiß er, dass das zusammengefasst gesucht werden soll.

Ähnlich wie man Tags für Videos bei Youtube trennt.

ollo

||||||||||||

schnuffke2

||||||||||

einseinsnull

[nur noch PN]

Ich denke mal, das trennt einfach die Suchwörter voneinander.

ich bin gerade zu einem ganz anderen schluss gekommen.

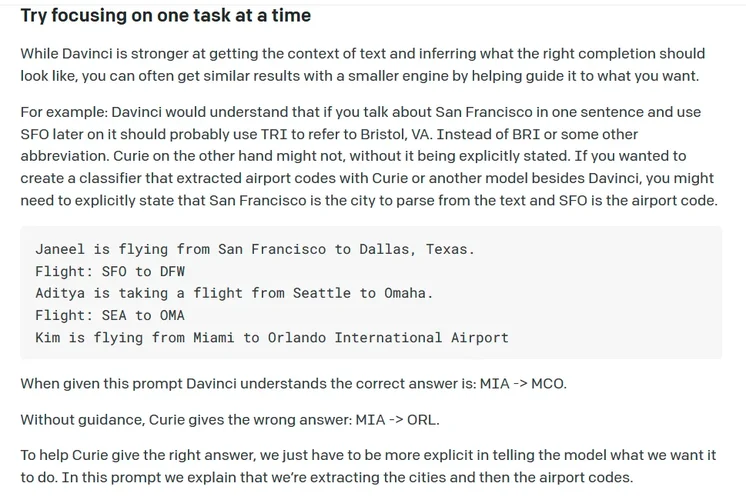

laut der projektbeschreibung von openAI besteht der teil der API, den ich mal in ermangelung des richtigen begriffs als "input parser" bezeichnen möchte, aus einem oder mehreren modellen, wie die eingegebenen daten (also z.b. hier der text) interpretiert werden.

das ganze funktioniert also zunächst einmal ganz ohne, dass man modelle selbst entwerfen müsste, weil die enthaltenen modelle bereits genug "techniken" für anwendungen wie sprache, logik, einfache dateistrukturen wie pixelgraphiken, tabellen, netze oder mengen mitbringen.

openAI gehört, anders als ich dachte, zu den sogenannten generischen intelligenzen, ist also quasi alleskönner.

dann bliebe nur noch eine große variable, nämlich wie und welcher content unsern dalli ursprünglich mal bekannt gemacht wurde. (dazu habe ich mich schon ausgelassen, dateinamen, bildunterschriften usw. ...warum er russische vokablen auch mit lateinischen buchstaben erfasst ist mir nicht so ganz klar)

das einzige was wir dazu wissen, ist, dass soundsoviele zigtausend stunden GPU berechung durchgeführt wurden, aber nicht wie die bilder gefunden wurden.

Zuletzt bearbeitet:

Area88

||||||||||||

Letzteres scheint dem Dalli schnurz zu sein, auch hat er (sie?) eine unterentwickelte Personenkenntnis:sowas wie "eiffelturm im regenwald" kann er - scheinbar - semantisch deuten.

ich bin mir aber nicht sicher, ob man ihm das bewusst gezeigt hat, ob er sich das aus anderen bildunterschriften ganz anderer bilder selbst erabeitet hat ("a in b" = "a ist kleiner und irgendwo in der mitte" ??) und mir fällt auch so spontan kein test dafür ein. :)

den unterschied zwischen a b c und a, b, c habe ich auch noch nicht geschnallt.

Area88

||||||||||||

Dem scheint leider nicht so zu sein. Ich habe nebenbei mehrere vergleichende dahingehende Versuchsreihen gemacht und meine feststellen zu können, dass das Komma keinerlei Einfluss auf das generierte Bild hat. Wenn jemand andere Erkenntnisse gewonnen hat, möge er diese hier bitte zeigen.Wenn er King Kong nehmen soll, könnte er nach den beiden einzelnen Wörtern gucken, also auch Bilder mit einem König als Vorlage nehmen, wenn King Kong aber mit einem Komma vom Rest getrennt ist, weiß er, dass das zusammengefasst gesucht werden soll.

Hier mein "King, Kong - versus King Kong" -Test:

Wenn Deine These, dass das Komma einen separierenden Effekt ausübt zuträfe, hätte bei den ersten 6 Bildern eine Person (oder ein Affe?) mit Krönchen, Zepter oder einem anderen typisch "königlichen" Utensil (vielleicht ein Thron?) auftauchen müssen.

Zuletzt bearbeitet:

Area88

||||||||||||

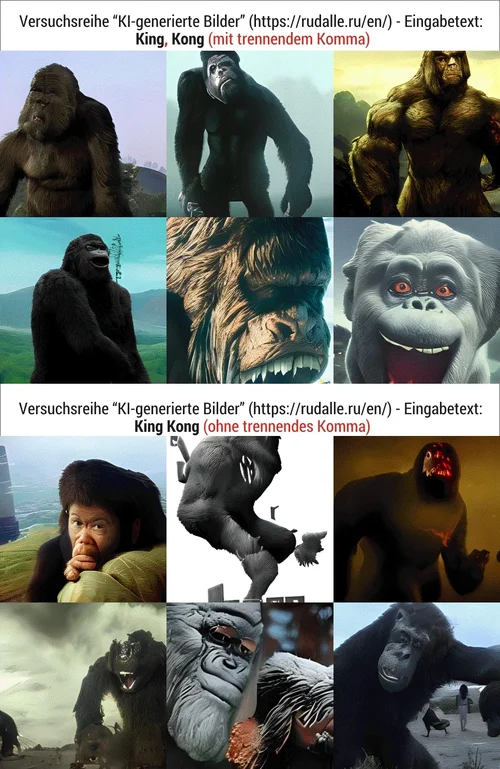

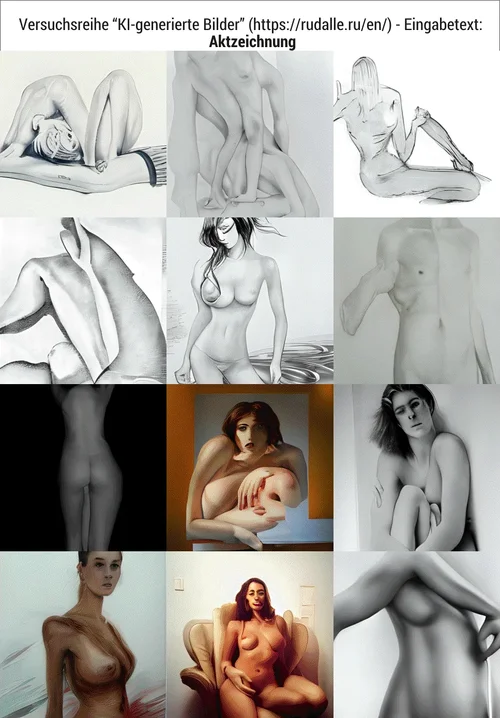

Seltsam ist, dass die KI den Begriff "Akt" weder künstlerisch, noch biologisch interpretiert, sondern ihn eher so wie im Sprachgebrauch der Österreicher sieht, die unter "Akt" die deutsche "Akte" verstehen. Ich habe dahingehend 6 Versuche durchgeführt und immer kam irgendwelches bedrucktes Papiergedöhns™ (zeig' ich jetzt nicht...)

Aber:

Verwendet man stattdessen das Compositum "Aktzeichnung", dann erscheinen bei 12 von 12 Versuchen Ergebnisse die erwartungserfüllend ausfallen, wobei es nicht immer Zeichnungen im engeren Sinne sind aber immerhin bildliche Aktdarstellungen, mal mit Tusche gezeichnet, mal mit Graphitstift, mal gepinselt, aber immer brauchbar.

Aber:

Verwendet man stattdessen das Compositum "Aktzeichnung", dann erscheinen bei 12 von 12 Versuchen Ergebnisse die erwartungserfüllend ausfallen, wobei es nicht immer Zeichnungen im engeren Sinne sind aber immerhin bildliche Aktdarstellungen, mal mit Tusche gezeichnet, mal mit Graphitstift, mal gepinselt, aber immer brauchbar.

betadecay

Dronemaster Flash

Sofern man sich nicht daran stört, dass die Leute 3 Beine haben und ihnen ein Arm aus dem Kopf wächst ;)Verwendet man stattdessen das Compositum "Aktzeichnung", dann erscheinen bei 12 von 12 Versuchen Ergebnisse die erwartungserfüllend ausfallen, wobei es nicht immer Zeichnungen im engeren Sinne sind aber immerhin bildliche Aktdarstellungen, mal mit Tusche gezeichnet, mal mit Graphitstift, mal gepinselt, aber immer brauchbar.

Spass beiseite: manchmal sieht es sogar nach Picasso aus.

News

-

News Umsturz 2026 - SequencerTalk 264 - die letzte in diesem Jahr - live

- Gestartet von Moogulator

- Antworten: 1

-

News 2025-12-20 Shiny Toys, Dortmund - Musik Festival Reihe IV

- Gestartet von Moogulator

- Antworten: 1

-

-

News CRYPTOBIOSIS (Performance-Musik-Mikrobiologie) - in Köln

- Gestartet von Moogulator

- Antworten: 0

-

-

-

News Next-Generation MIDI Controller kommen - eine ganze Ladung

- Gestartet von Moogulator

- Antworten: 1

App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.