App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

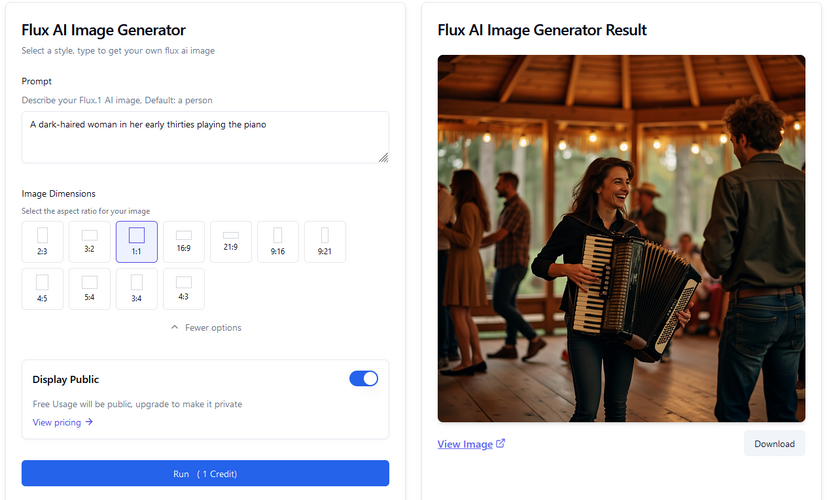

Neueste KI zur Bilderzeugung

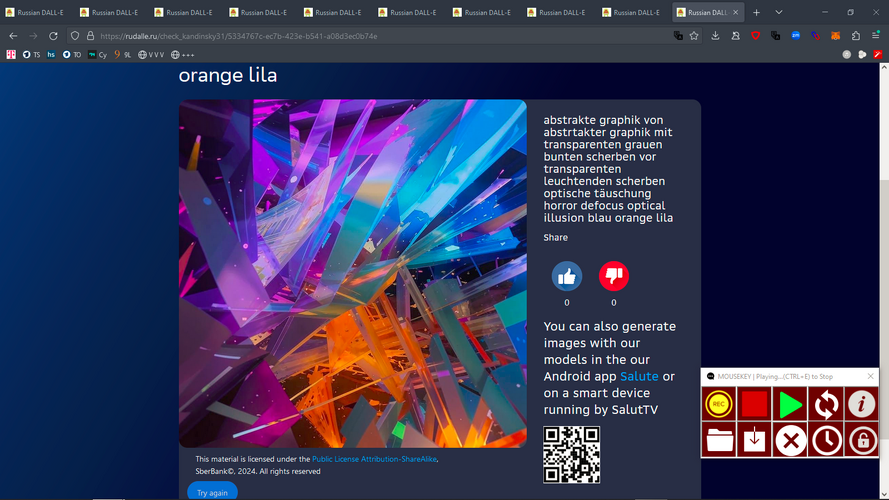

- Ersteller Lois

- Erstellt am

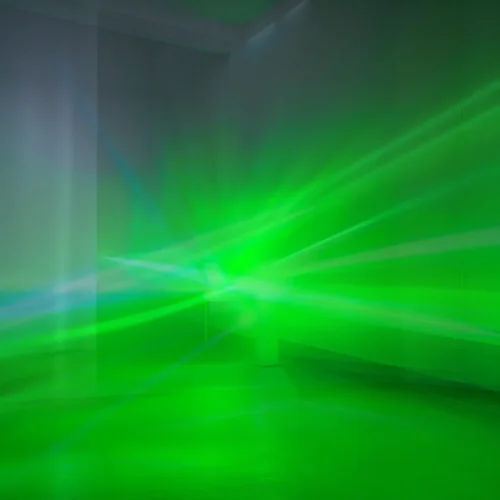

Golden-Moon

Ambient...to the sky and back

Auf Plexiglas gedruckt, mit Hintergrundbeleuchtung wär das sicherlich ein Hingucker.

einseinsnull

[nur noch PN]

ja, nach einer CMYK konversion bliebt von der floureszenz leider nicht mehr viel übrig.

sieht definitiv auf bildschirmen besser aus als auf leinwand.

sieht definitiv auf bildschirmen besser aus als auf leinwand.

DanDay

Absoluter Amateur

darkstar679

Wood fertiliser

ich bin neu mit KI dingen.

was muß man eingeben, um ein solches bild zu erzeugen?

was ich bisher versucht habe kam ziemlich langweilig rüber.

darkstar679

Wood fertiliser

einseinsnull

[nur noch PN]

darkstar679

Wood fertiliser

verstehe. Software für den Rechner. Das sieht wie so eine Bastelversion eines Programms aus.Die Generierung läuft bei mir lokal auf dem PC mit ComfyUI (Github Link), ich nutze keine Onlinedienste für sowas.

Das wäre nicht das richtige für mich. Dafür bin ich nicht firm genug mit dem Computer.

Danke aber die die Erklärung.

einseinsnull

[nur noch PN]

einseinsnull

[nur noch PN]

Golden-Moon

Ambient...to the sky and back

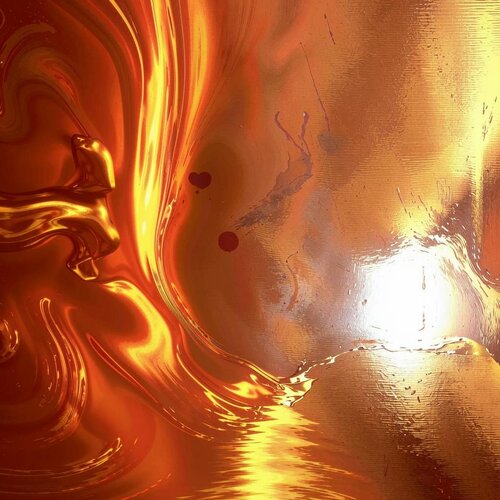

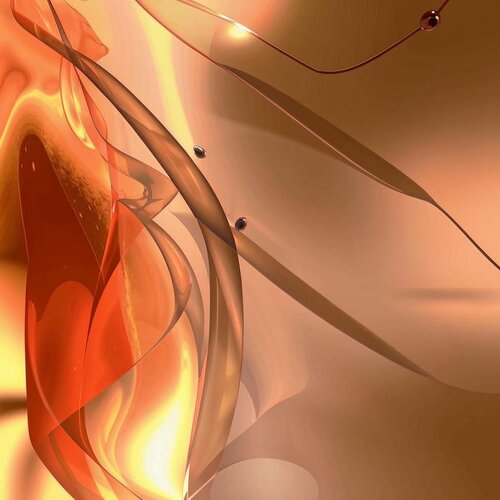

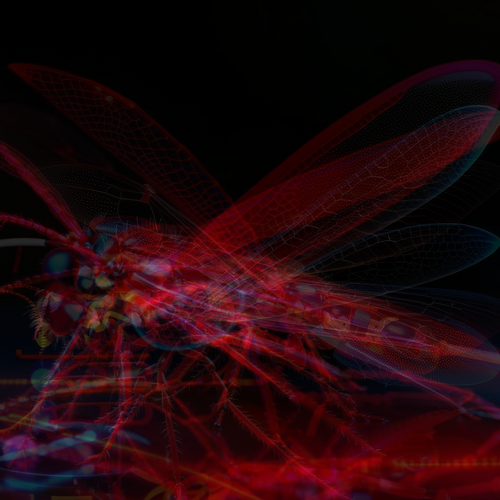

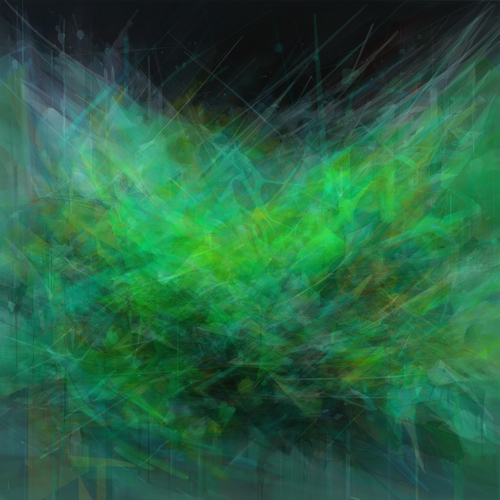

Definitiv!das hier habe ich weder bestellt noch wären die dinge, die man sieht, auch nur annähernd in der prompt enthalten gewesen (ist nämlich die gleiche wie oben). aber irgendwie ist es geil:

einseinsnull

[nur noch PN]

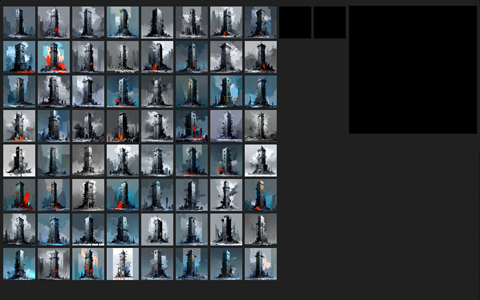

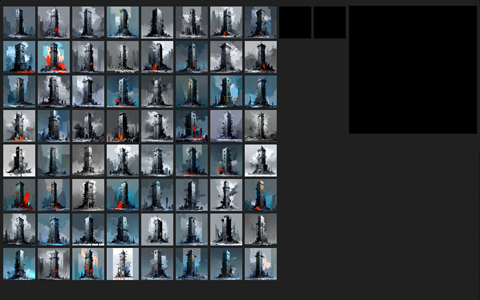

eine meine aktuellen lieblingstechniken ist immer noch ähnliche bilder - z.b. so wie diese KI sachen - gleichförmig zusammenzumischen. etwas einfacheres gibt es theoretisch betrachtet fast nicht, aber es ist genau deswegn recht effektiv.

alternativ dazu bietet sich an andere lineare copymodes wie z.b. ineinanderkopieren oder screen zu benutzen.

dazu habe ich mir einen kleinen browser gebaut, wo man sie 100 stück weise sehen und dann circa 7-16 davon auswählen kann, dann wird auf knopfdruck eine vorschau erstellt und/oder gerendert.

alternativ dazu bietet sich an andere lineare copymodes wie z.b. ineinanderkopieren oder screen zu benutzen.

dazu habe ich mir einen kleinen browser gebaut, wo man sie 100 stück weise sehen und dann circa 7-16 davon auswählen kann, dann wird auf knopfdruck eine vorschau erstellt und/oder gerendert.

Zuletzt bearbeitet:

einseinsnull

[nur noch PN]

haha, sowas wie "automatisches sortieren" wäre hier in der tat ganz sinnvoll, und zwar immer dann, wenn ein KI prompt so gut ist, dass ich nicht eines sondern 50 hunderterpakete mit zusammengehörigen mache.

bei meinen algorithmischen sachen die ich direkt in max oder GL mache kann ich das ergebnis steuern, bei diesem nicht-lokalen dall-e zeug entsteht fast immer eine gewisse bandbreite an graphisch sehr unterschiedlichen fragmenten.

bei meinen algorithmischen sachen die ich direkt in max oder GL mache kann ich das ergebnis steuern, bei diesem nicht-lokalen dall-e zeug entsteht fast immer eine gewisse bandbreite an graphisch sehr unterschiedlichen fragmenten.

Zuletzt bearbeitet:

einseinsnull

[nur noch PN]

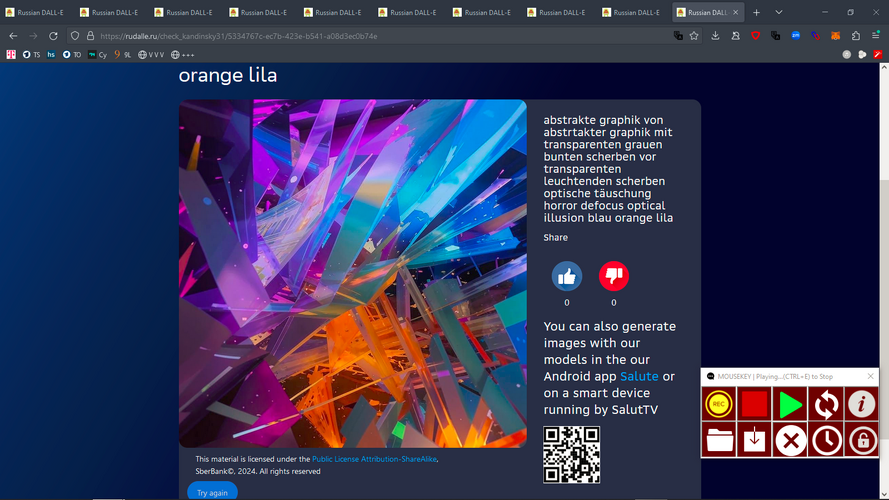

das dall-e von microsoft ja ja ein ziemlich mist. das kommt immer mit irgendwelchen bekloppten styles daher, die man nicht selbst eingegeben hat. das sieht dann alles aus wie lego.

mit den russen bin ich echt glücklich. und obige layer technik behebt ja auch das kompressionsartefakte problem.

mit den russen bin ich echt glücklich. und obige layer technik behebt ja auch das kompressionsartefakte problem.

Zuletzt bearbeitet:

einseinsnull

[nur noch PN]

KI-basiert ist zu komplex für mich, wobei es vermutlich auf einem mac pro 2012 schon laufen würde.

aber es passte nicht ganz zur aufgabe. die entscheidung darüber, was ähnlich ist oder aus anderen gründen zusammenpassen könnte muss hier tendenziell teil des schöpferisches prozesses bleiben.

leider ist maxmsp richtig scheiße darin dateien zu verschieben, zu kopieren oder ordnerstrukturen zu erzeugen.

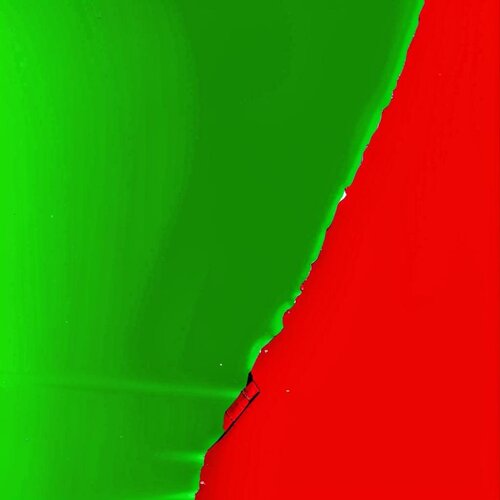

bin gerade dabei den dalli quatsch mit metasynth zu kombinieren. rot und grün stehen in metasynth für die amplitude von links und rechts.

farben sind geräusche sind essen sind sex...

aber es passte nicht ganz zur aufgabe. die entscheidung darüber, was ähnlich ist oder aus anderen gründen zusammenpassen könnte muss hier tendenziell teil des schöpferisches prozesses bleiben.

leider ist maxmsp richtig scheiße darin dateien zu verschieben, zu kopieren oder ordnerstrukturen zu erzeugen.

bin gerade dabei den dalli quatsch mit metasynth zu kombinieren. rot und grün stehen in metasynth für die amplitude von links und rechts.

farben sind geräusche sind essen sind sex...

ollo

||||||||||||

Ich habe jetzt mal FLUX shuttle 3 in ComfyUI zum Laufen gebracht. Da ich Comfy vorher nie so richtig genutzt habe, sondern alles über A1111 lief, war das nicht ganz einfach aber jetzt geht es. Da das Ganze nur 4 Steps braucht, geht es recht zügig und damit auch annehmbar, was den Stromverbrauch betrifft. Die Graka (4070) verhält sich jedenfalls beim Stromziehen anders als bei Stable Diffusion 1.5 und XL unter A1111.

Erstes Fazit: Menschen kann das Model nicht so gut, die sehen doch recht künstlich aus. Die Plattenspieler mit der Draufsicht dagegen sind die besten Plattenspieler bisher. Die Landschaft sieht auch gut aus. Nichts davon ist upscaled sondern es sind die direkten Auflösungen.

Erstes Fazit: Menschen kann das Model nicht so gut, die sehen doch recht künstlich aus. Die Plattenspieler mit der Draufsicht dagegen sind die besten Plattenspieler bisher. Die Landschaft sieht auch gut aus. Nichts davon ist upscaled sondern es sind die direkten Auflösungen.

ollo

||||||||||||

Wenn du noch nicht hast, guck mal nach Afterburner Link, ist von MSI und werbefrei, damit kannst du den Strombedarf deiner Karte einbremsen bei nur sehr wenig Verlust der Rechleistung. Meine 4090 läuft nur mit 60 bis maximal 65% der zulässigen 450Watt und verliert nur 8% bei den Iterationen pro Sekunde. Leise Lüfter inklusive.

Anhang anzeigen 235280

Und mit HWMonitor Link, kannst du sehen, wieviel dann absolut gezogen wird. Zeigt auch andere nützliche Sachen wie deine VRAM Auslastung an und mehr.

Anhang anzeigen 235281

Ich hab direkt in der Nvidia App die Graka auf 75% gedrosselt, das merkt man kaum bei der Berechnung, spart aber 50Watt ein und die Karte bleibt wesentlich Kühler.

HWMonitor nutze ich auch lange, der zeigt aber ganz andere Werte unter Power an als bei Stable Diffusion unter A1111. Einer der Werte war unter A1111 immer bis zu 150Watt, was dann genau dem Verbrauch der Graka entsprechen würde. Jetzt bei Comfy ist die Verteilung der Watt dort ganz anders. Muss ich mir nochmal genau anschauen, was eigentlich die Werte genau sind.

Jetzt habe ich den HWMonitor auch mal aktualisiert, sieht jetzt ehh alles anders aus. Bei dem Strohmzähler am Stecker an dem der PC dranhängt, kommt es in etwa auf das selber aus.

einseinsnull

[nur noch PN]

einseinsnull

[nur noch PN]

KleinKlang

.....

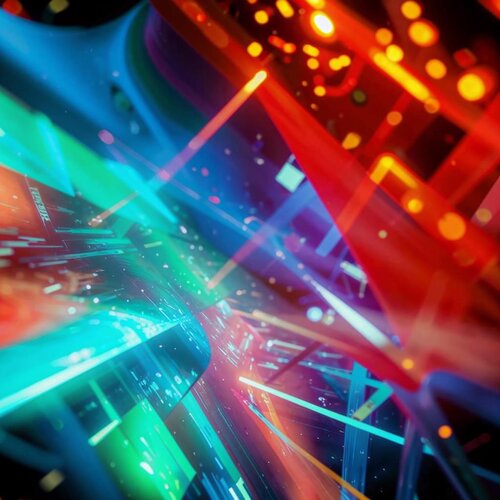

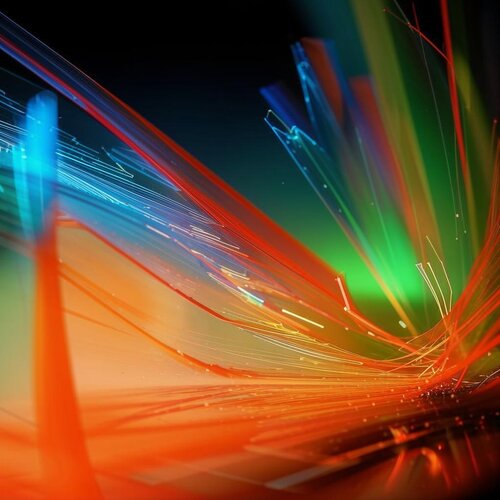

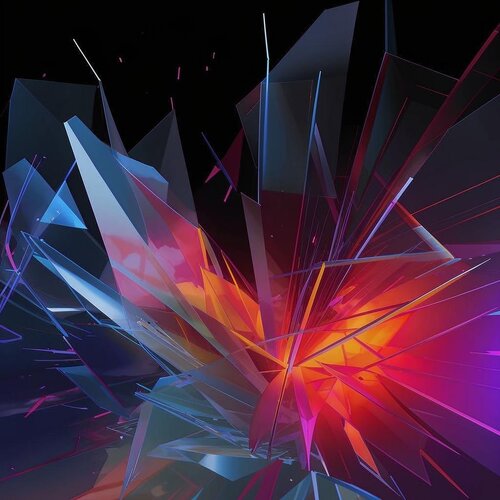

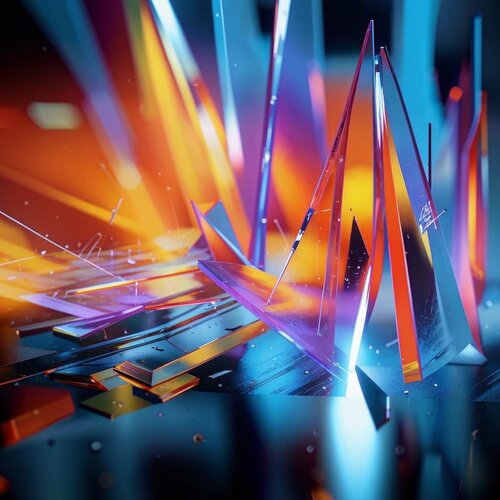

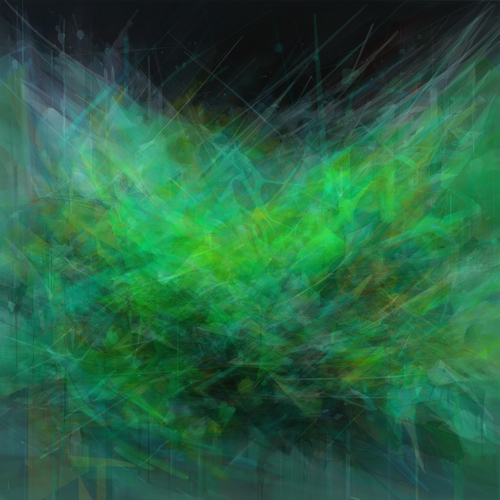

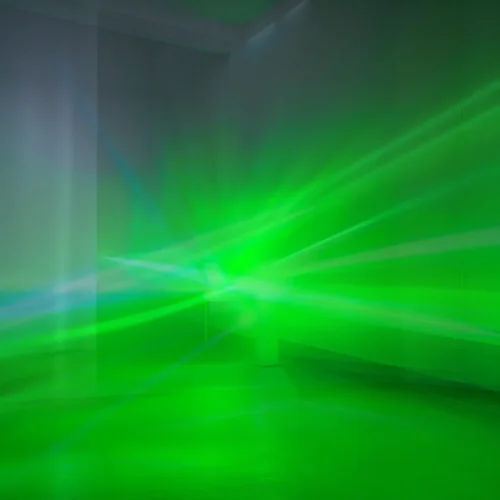

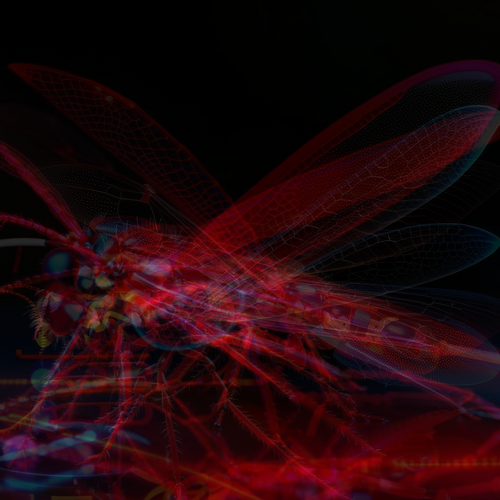

Finde ich auch sehr geil deine abstrakten Bilder! Teilst du den prompt? Oder ist der auch auto-generiert?bester prompt ever. habe heute nacht 5000 davon generieren lassen.

mehr als 3% davon könnte man direkt so an die wand hängen. einseinsnull schafft sich ab.

Anhang anzeigen 232468 Anhang anzeigen 232469

Anhang anzeigen 232470 Anhang anzeigen 232471

einseinsnull

[nur noch PN]

abstrakte floureszierende graphik von abstrakte, gebilde neben umgeworfenen lichtschwert in transparenter scherbenkammer grün blau bleu türkis leuchtend rot orange seile optische täuschung defocus

(K v3.1)

sei nicht traurig wenn sie bei dir anders aussehen, es geht nicht mit jedem finger und man muss auch im richtigen moment klicken.

der tippfehler mit dem komma dürfte irrelevant sein da er vermutlich autokorrigiert wird.

hab unter dem letzten bild auch noch mal die prompt ergänzt.

und hier nochmal ein kleiner tipp wie es schneller geht. (nur kandinsky 3.1, die älteren sind schwieriger, nur diese webseite)

10 tabs machen und einen mouserecorder besorgen.

das schnell-klicken eine weile üben bis es sitzt und/oder das maus/keyboard script editieren um zeiten zu verkürzen oder delays ganz rauszunehmen (achtung, geht nicht mit jedem task im browser)

die erste runde manuell fertig machen bis zum download - danach nur noch das script benutzen.

script:

back button

paste

return

manuell:

captcha lösen

warten (falls nötig)

download (bei gefallen) per "graphik in neuem tab öffnen" (kontextmenu firefox) *)

*) in neuem tab öffnen geht nämlich garnicht, sondern das startet direkt den download und erzeugt dateien der marke "meine tolle prompt 01", "meine tolle prompt 02".

telegram ist zwar ohne captcha, aber langsamer und fehlerbehafteter.

das scheiß schiebedings löst man am besten, indem man nicht über die gewünschte position hinaus schiebt (und dann zurück muss), sondern indem man sich langsam annähert. wenn man die maus dabei schräg nach unten zieht (und nicht nur nach rechts) geht das dann relativ einfach.

(K v3.1)

sei nicht traurig wenn sie bei dir anders aussehen, es geht nicht mit jedem finger und man muss auch im richtigen moment klicken.

der tippfehler mit dem komma dürfte irrelevant sein da er vermutlich autokorrigiert wird.

hab unter dem letzten bild auch noch mal die prompt ergänzt.

und hier nochmal ein kleiner tipp wie es schneller geht. (nur kandinsky 3.1, die älteren sind schwieriger, nur diese webseite)

10 tabs machen und einen mouserecorder besorgen.

das schnell-klicken eine weile üben bis es sitzt und/oder das maus/keyboard script editieren um zeiten zu verkürzen oder delays ganz rauszunehmen (achtung, geht nicht mit jedem task im browser)

die erste runde manuell fertig machen bis zum download - danach nur noch das script benutzen.

script:

back button

paste

return

manuell:

captcha lösen

warten (falls nötig)

download (bei gefallen) per "graphik in neuem tab öffnen" (kontextmenu firefox) *)

*) in neuem tab öffnen geht nämlich garnicht, sondern das startet direkt den download und erzeugt dateien der marke "meine tolle prompt 01", "meine tolle prompt 02".

telegram ist zwar ohne captcha, aber langsamer und fehlerbehafteter.

das scheiß schiebedings löst man am besten, indem man nicht über die gewünschte position hinaus schiebt (und dann zurück muss), sondern indem man sich langsam annähert. wenn man die maus dabei schräg nach unten zieht (und nicht nur nach rechts) geht das dann relativ einfach.

Zuletzt bearbeitet:

KleinKlang

.....

Danke, den Service kannte ich noch gar nicht, dachte du verwendest auch flux oder stable Diffusionabstrakte floureszierende graphik von abstrakte, gebilde neben umgeworfenen lichtschwert in transparenter scherbenkammer grün blau bleu türkis leuchtend rot orange seile optische täuschung defocus

(K v3.1)

sei nicht traurig wenn sie bei dir anders aussehen, es geht nicht mit jedem finger und man muss auch im richtigen moment klicken.

der tippfehler mit dem komma dürfte irrelevant sein da er vermutlich autokorrigiert wird.

hab unter dem letzten bild auch noch mal die prompt ergänzt.

und hier nochmal ein kleiner tipp wie es schneller geht. (nur kandinsky 3.1, die älteren sind schwieriger, nur diese webseite)

10 tabs machen und einen mouserecorder besorgen.

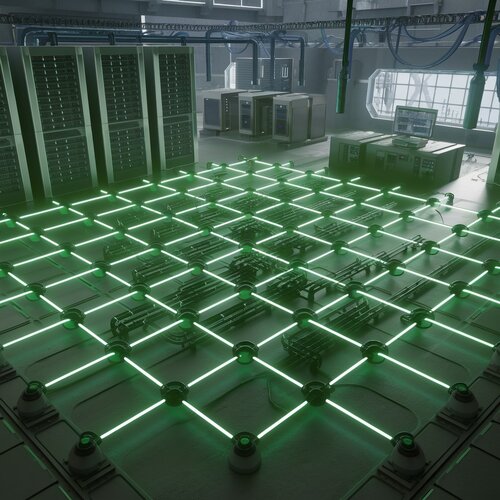

Anhang anzeigen 236976

das schnell-klicken eine weile üben bis es sitzt und/oder das maus/keyboard script editieren um zeiten zu verkürzen oder delays ganz rauszunehmen (achtung, geht nicht mit jedem task im browser)

die erste runde manuell fertig machen bis zum download - danach nur noch das script benutzen.

script:

back button

paste

return

manuell:

captcha lösen

warten (falls nötig)

download (bei gefallen) per "graphik in neuem tab öffnen" (kontextmenu firefox) *)

*) in neuem tab öffnen geht nämlich garnicht, sondern das startet direkt den download und erzeugt dateien der marke "meine tolle prompt 01", "meine tolle prompt 02".

telegram ist zwar ohne captcha, aber langsamer und fehlerbehafteter.

das scheiß schiebedings löst man am besten, indem man nicht über die gewünschte position hinaus schiebt (und dann zurück muss), sondern indem man sich langsam annähert. wenn man die maus dabei schräg nach unten zieht (und nicht nur nach rechts) geht das dann relativ einfach.

einseinsnull

[nur noch PN]

Lois

|||||

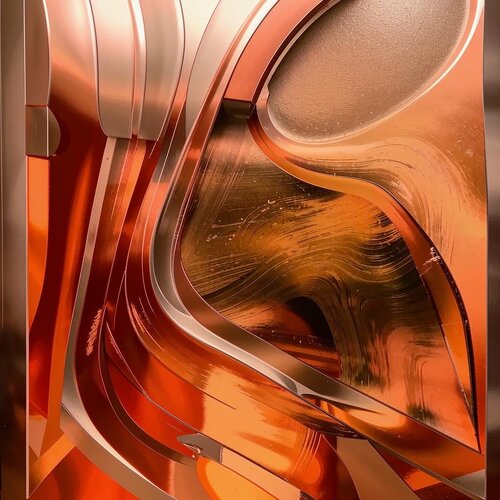

Das ist erstaunlichMercedes-Benz ist …

einseinsnull

[nur noch PN]

hin und wieder gebe ich versehentlich "v" ein, das ergibt auch oft komplexe darstellungen.

einseinsnull

[nur noch PN]

Similar threads

- Antworten

- 1K

- Aufrufe

- 169K

- Frage

- Antworten

- 218

- Aufrufe

- 12K

- Antworten

- 7

- Aufrufe

- 1K

- Antworten

- 90

- Aufrufe

- 8K

T

- Antworten

- 97

- Aufrufe

- 7K

T

Neueste Beiträge

-

-

-

-

-

-

Beat only Competition Abstimmung + Diskussion Folge Competion / Gemeinschaft

- Letzter: electric guillaume

News

-

2025-04-12 Lille, Kompromat + Ippon - Bilder aus laufender Tour

- Gestartet von Moogulator

- Antworten: 3

-

News 11+14.4.2025 SequencerTalk 238 Live vom Synthfest Frankreich & Modular Speicherbar - live 20:30 jeweils - Ab DANN Montags regulär

- Gestartet von Moogulator

- Antworten: 2

-

-

Tubbutec Programmer für Synthesizer Zusatzfunktionen - MonoPoly, MC202, Juno 60 etc

- Gestartet von Moogulator

- Antworten: 7

-

News SequencerTalk 237 - Drei-Vier-Synclavier - Rückkehr mit anderem Preis, Granular Module und Radio - live 20:30

- Gestartet von Moogulator

- Antworten: 1

-

News Synclavier Keyboard kommt zurück als Ork II (mit Regen als Basis)

- Gestartet von Moogulator

- Antworten: 0

-

Frequency Central Florian - die Synth Stimme Roland-Style

- Gestartet von Moogulator

- Antworten: 11