App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Was spricht für KI - Anekdoten und Erlebnisse mit KI, GPT und Schwächen und Grenzen im System.

- Ersteller Moogulator

- Erstellt am

-

- Schlagworte

- ai chat gpt ki künstliche intelligenz

Scenturio

au͘͏͡d̛̀i̛͝a͞ţ͏u͏r ̷͜et ̶͟͝a͡l͜t͢͡͠e͜͠ŗa ͝p͢a̛rs

es geht vermutlich darum, dass es nach dem Gefühl einiger Leute langsam Zeit wäre für die Asimov'schen Robotergesetze ... aber es ist noch nicht gelunden, diese anständig zu implementieren (abgesehen von ein paar primitiven Zensurfiltern und Bias-Anpassungen).Man gibt die Anweisung "at all costs". Und dann wundert man sich, dass die KI solchen Text ausgibt? Was erwarten die Leute? Dass die KI sagt: "Sorry, I can't do that, Dave?"

Lefty de Vito

Abbildung ähnlich

Sofür eine ki spricht, dass sie besser als google funkioniert.

Moogulator

Admin

Ja, du kannst sogar den regulären schon so etwas wie ein Urteil abringen.Gibt es schon KI-Software, die Musik "hören" und analysieren kann?

zB kann man Gemini darum bitten und bekommt dann auch ein Ergebnis.

Dieses neue Feature von Google Gemini ist der Retter für Musikproduzenten!

Der KI-Chatbot Google Gemini kann in einer neuen Version eure Tracks analysieren und euch Feedback zu Arrangement und Mix geben.

Klinke

|||||

Das mußt Du mir erklären. Vor allem das "selbst anfängt". Das Verändern von Gewichten nach mathematischen Regeln hat meiner Meinung nach nämlich sehr wenig mit "selbst anfangen" zu tun, falls es irgendein NN Algoryhtmus gibt, der darüber hinausgeht, würde ich sehr gerne mehr darüber lernen.dass die KI selbst anfängt Algorythmen zu vernetzen...

Scenturio

au͘͏͡d̛̀i̛͝a͞ţ͏u͏r ̷͜et ̶͟͝a͡l͜t͢͡͠e͜͠ŗa ͝p͢a̛rs

au ja, und dann für Battles als Plugin ins Forum integrieren. So spart man sich die umständliche Abstimmphase.zB kann man Gemini darum bitten und bekommt dann auch ein Ergebnis.

Rolo

*****

Wenn mir jemand auf der Straße etwas erzählt überprüfe ich das immer zu Hause. Da guck ich dann auch ob die Meldung nicht nur irgendwo ganz alleineDer Sinn von Fake News ist nicht die Fake news selbst, sondern dass die Leute einfach überhaupt niemandem mehr glauben. Schon gar nicht der echten News. Die KI scheint ein guter Baustein dazu zu sein.

präsent ist, sondern ob auch seriöse Sender darüber berichten.

Es heute ja leichter als früher. Ein Gerücht das sich auf der Straße verbreitet hatte konnte man nicht nachprüfen /auf den Grund gehen. Heute geht das.

Mir erzählt jemand was und ich kann es nachprüfen.

Bitlaw

Paz

Würde wirklich zu weit führen dir das hier zu erklären...Das mußt Du mir erklären. Vor allem das "selbst anfängt". Das Verändern von Gewichten nach mathematischen Regeln hat meiner Meinung nach nämlich sehr wenig mit "selbst anfangen" zu tun, falls es irgendein NN Algoryhtmus gibt, der darüber hinausgeht, würde ich sehr gerne mehr darüber lernen.

smallie

|||||

goorooj hat dazu vor einer Weile etwas kluges gesagt, das habe ich mir gemerkt:Der Sinn von Fake News ist nicht die Fake news selbst, sondern dass die Leute einfach überhaupt niemandem mehr glauben. Schon gar nicht der echten News. Die KI scheint ein guter Baustein dazu zu sein.

Das galt schon immer und jetzt gilt es noch mehr.Wissen ist jetzt die Fähigkeit, dort Wahrheit von Fälschung, Fakten von Geschwurbel unterscheiden zu können und dabei hiltft uns... nur unser erlerntes, erlebtes Wissen.

smallie

|||||

Die Robotergesetze zu implementieren halte ich für schwierig bis unmöglich.es geht vermutlich darum, dass es nach dem Gefühl einiger Leute langsam Zeit wäre für die Asimov'schen Robotergesetze ... aber es ist noch nicht gelunden, diese anständig zu implementieren (abgesehen von ein paar primitiven Zensurfiltern und Bias-Anpassungen).

In einem neuronalen Netz ist ja nichts hartcodiert. Man müßte erst die Stellen in den Gewichten der Neuronen finden, die "Mensch", "Roboter", "verletzen" usw. codieren, um dort Sperren einzubauen. Nur wird das nicht eine Stelle sein, sondern hunderte oder tausende. Ich bin sehr skeptisch, ob sich das technisch verwirklichen läßt. Dem Gendanken eines lernfähigen Systems widerspricht das auch.

Die Implementierung müßte etwas sein, dass ein Roboter nicht erst lernen muß. Ein Instinkt wie der Greifreflex eines Babies oder wie Blinzeln, wenn uns etwas vor's Auge fliegt. Hartcodieren in einer der üblichen Programmiersprachen oder mittels eines Expertensystems scheidet aus, weil sich so nur sehr begrenztes Weltwissen unterbringen läßt. Also eine weitere KI mit fixierten Gewichten. Womit man sich das selbe Problem einhandelt, dass früher oder später ein Fall auftritt, der nicht in den Trainingsdaten steckte.

Ich denke, KIs oder Roboter werden ähnliche Fehler machen, wie Menschen. Und obendrein welche, die wir uns nicht hätten ausdenken können.

Ich war mit meiner Tochter beim Essen. Da war sie vielleicht fünf. Auf dem Tisch stand ein Schild mit der Tischnummer 6. Sag ich: wenn du das Schild auf den Kopf stellst, ist es eine Neun. Sie nimmt es - und stellt das Schild auf ihren Kopf.

Nochmal goorooj:

Und man sammelt noch heute. Jeder Unfall wird von den Luftfahrtbehörden untersucht. Gegebenenfalls werden Abläufe, Technik oder das Training angepasst. Das wird bei autonomen Robot-Fahrzeugen oder Lieferdrohnen nicht anders sein.Jetzt werden die ersten Erfahrungen mit KI gesammelt... genauso wie damals als das Fliegen neu war. da wusste man auch noch nicht was alles passieren kann und musste Erfahrungen sammeln.

G

GegenKlang

||||||||

Nicht einmal hier in diesem Thread ist also richtig Positives über KI zu vermelden, kann es sein?

Zumindest nichts Geprüftes. Da behauptet zuletzt also ein Webware-Hersteller oder lanciert Testberichte, dass eine KI Feedback zu meiner Mucke geben kann. Bämm, Link ins Forum erbrechen, Eindruck machen, sich gar ganz toll fühlen. Was soll das? Selber probiert? Upload and AI-Feedback or it ain't happen. Es würde mich schon interessieren, ob Gemini merkt, wenn ich ihm ein Song vorwerfe, der kein Song ist, sondern eine Freifeldaufnahme oder so. (Sagen wir, vom örtlichen Stadtteich, aber dass sie das erkennt, sollte man nicht verlangen). Kann das jemand für mich machen, bitte? Bin gerade selber zu faul, aber wenn es mir wirkich unter den Nägeln brennt, muss ich mal über meinen Schatten springen, werd ich mal gucken, was Gemini zu meiner missratenen, letztlich nicht eingereichten "Spoken Word Challenge"-Kontribution meint.

Aber nimmst du dir auch immer die Zeit? Wahnsinn, wie viel du wohl davon hast, wenn du wirklich alles nachprüfst, selbst zu Themen, die dich gar nicht interessieren.

Sobald man Fake-News vernimmt und vergisst nachzuprüfen oder kritisch zu hinterfragen, und später vernimmt man sie nochmal, ist man (sicher auch du!) stärker geneigt daran zu glauben als beim ersten Mal. So funktioniert der Kopf, da gilts aufzupassen. Und dann stampedet eben schnell mal eine bunte Büffelherde durch Stockholm, und die dortigen Bewohner wundern sich, wenn sie erst in den internationalen "seriösen" Medien davon erfahren.

Wer ein Query einer Websuchmaschine mit "Recherche" verwechselt, für den ist auch ein paar Deosprühstöße unter die Achseln ein Vollbad. Recherche, die den Namen verdient, erfolgt in kostenpflichtigen Pressedatenbanken und selbst darin ist weißgott nicht alles Gold, das glänzt.

Zumindest nichts Geprüftes. Da behauptet zuletzt also ein Webware-Hersteller oder lanciert Testberichte, dass eine KI Feedback zu meiner Mucke geben kann. Bämm, Link ins Forum erbrechen, Eindruck machen, sich gar ganz toll fühlen. Was soll das? Selber probiert? Upload and AI-Feedback or it ain't happen. Es würde mich schon interessieren, ob Gemini merkt, wenn ich ihm ein Song vorwerfe, der kein Song ist, sondern eine Freifeldaufnahme oder so. (Sagen wir, vom örtlichen Stadtteich, aber dass sie das erkennt, sollte man nicht verlangen). Kann das jemand für mich machen, bitte? Bin gerade selber zu faul, aber wenn es mir wirkich unter den Nägeln brennt, muss ich mal über meinen Schatten springen, werd ich mal gucken, was Gemini zu meiner missratenen, letztlich nicht eingereichten "Spoken Word Challenge"-Kontribution meint.

Du kannst es, richtig.Heute geht das.

Mir erzählt jemand was und ich kann es nachprüfen.

Aber nimmst du dir auch immer die Zeit? Wahnsinn, wie viel du wohl davon hast, wenn du wirklich alles nachprüfst, selbst zu Themen, die dich gar nicht interessieren.

Sobald man Fake-News vernimmt und vergisst nachzuprüfen oder kritisch zu hinterfragen, und später vernimmt man sie nochmal, ist man (sicher auch du!) stärker geneigt daran zu glauben als beim ersten Mal. So funktioniert der Kopf, da gilts aufzupassen. Und dann stampedet eben schnell mal eine bunte Büffelherde durch Stockholm, und die dortigen Bewohner wundern sich, wenn sie erst in den internationalen "seriösen" Medien davon erfahren.

Wer ein Query einer Websuchmaschine mit "Recherche" verwechselt, für den ist auch ein paar Deosprühstöße unter die Achseln ein Vollbad. Recherche, die den Namen verdient, erfolgt in kostenpflichtigen Pressedatenbanken und selbst darin ist weißgott nicht alles Gold, das glänzt.

Moogulator

Admin

Das liegt aber auch daran, dass Kritik wie Positiv-Beispiele mehr oder weniger nicht so puristisch gesammelt werden.

robworld

AmbientRocker

Zumindest nichts Geprüftes. Da behauptet zuletzt also ein Webware-Hersteller oder lanciert Testberichte, dass eine KI Feedback zu meiner Mucke geben kann. Bämm, Link ins Forum erbrechen, Eindruck machen, sich gar ganz toll fühlen. Was soll das? Selber probiert? Upload and AI-Feedback or it ain't happen. Es würde mich schon interessieren, ob Gemini merkt, wenn ich ihm ein Song vorwerfe, der kein Song ist, sondern eine Freifeldaufnahme oder so. (Sagen wir, vom örtlichen Stadtteich, aber dass sie das erkennt, sollte man nicht verlangen). Kann das jemand für mich machen, bitte? Bin gerade selber zu faul, aber wenn es mir wirkich unter den Nägeln brennt, muss ich mal über meinen Schatten springen, werd ich mal gucken, was Gemini zu meiner missratenen, letztlich nicht eingereichten "Spoken Word Challenge"-Kontribution meint.

Die Bewertung eines Songs ist doch primär abhängig vom Prompt den du eingibst,

Für Fieldrecording macht ein Prompt wie der auf der verlinkten kein Sinn. Ohne es getestet zu haben tippe ich auf unter 5 von 100 ....

Bei Reddit haben ja einige es getestet und auch die Songs verlinkt:

https://www.reddit.com/r/SunoAI/comments/1hwcwbs/cant_find_anyone_to_listenrate_your_songs_search/#lightboxents/1bzzmy1/tried_analyzing_a_song_with_gemini_15_pro_now/

Die Analyzen sind je nach Prompt schon sehr detailliert

Rolo

*****

Ja, stimmt! selbst recherchieren kann ich es gar nicht. Ich müßte in Kriegsgebiete fahren und vorher in eine Zeitmaschine steigen um wirklich zu sehenAber nimmst du dir auch immer die Zeit? Wahnsinn, wie viel du wohl davon hast, wenn du wirklich alles nachprüfst, selbst zu Themen, die dich gar nicht interessieren.

ob dies oder das wirklich so oder so war. Ich vertraue da den Klassischen Medien das meinte ich damit. Wenn ich lese daß in Berlin Mäuse so groß

wie Elefanten unterwegs waren dann guck ich in meiner seriösen Zeitung (nicht die Bild) und weiß ob das stimmt oder nicht. Wobei ja die Bild Leute hat

die aus Kriegsgebieten berichten was ja schon crasser Aufwand ist. Aber ich mag die Bild Gesellschaftstechnisch nicht. Die hetzt mir zu viel. Ist halt

auch nur Boulevardpresse. Ich persönlich mag z.B. die Frankfurter Rundschau.

Rolo

*****

Ja, ....gewisses Einschätzungsvermögen für Dinge ist wichtig. Ich denke das habe ich. Aber genau das wiord durch KI ja verlorengehen wie manche prophezeien.Du kannst es, richtig.

Weil viele sich alles nur noch vorkauen lassen. Wahlomat z.B. ist keine KI , aber für mich genau so ein Tool. Für Leute die das ganze Jahr keine Zeitung lesen, keine Bundestagsdebatte oder Politsendung ansehen aber unbedingt wählen gehen wollen. Toll!

robworld

AmbientRocker

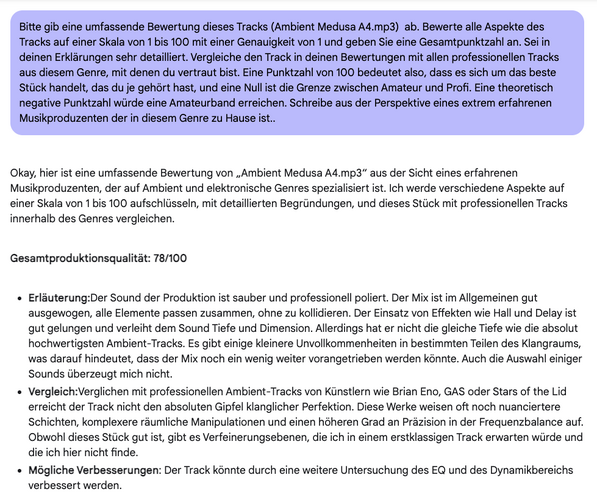

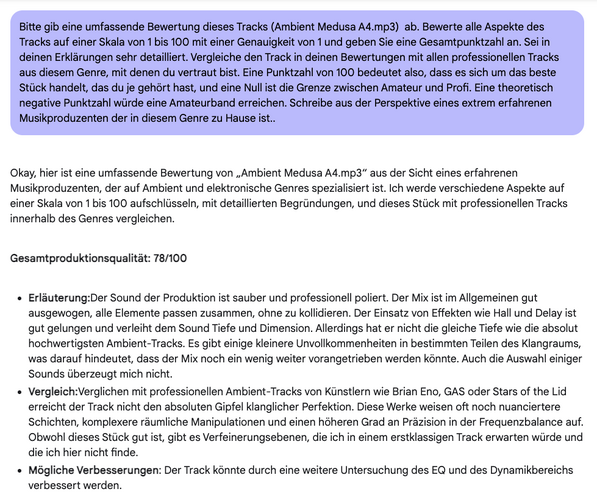

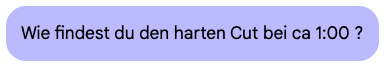

Ich hab jetzt mal aus Neugier in Googles AI Studio einen Track hochgeladen und von Gemini 2.0 Flash Experimental analyzieren lassen

Es sind nur 3 Stereo-Spuren, aufgenommen in AUM mit viel FX, Reverb, Delay, Lofi Tape FX,...

Koala Sampler (Berlin Streetnoise rund um den Hbf und Alex)

VirSn Teraverse (Pad im Hintergrund)

Polyend Medusa (im internen Gridsequencer programmiert, aber Sequencer wird Random abgespielt, während Aufnahme etwas am Filter und Hüllkurve etc gespielt.)

Anhang anzeigen Ambient Medusa A4.mp3

Die Analyse ist sehr wohlwollend formuliert, zeigt aber auch nachvollziehbar Schwachstellen auf (Mix, Dynamik/EQ, zu viel FX, etc)

Sounddesign und Texturen: 85/100

Zusammenfassung:

„Ambient Medusa A4“ ist ein gut produzierter und fachmännisch ausgeführter Track im Dark-Ambient-Genre. Das Sounddesign und die Gesamtproduktion sind stark und das Stück erzeugt eine konsistente und eindringliche Atmosphäre. Der Track ist angenehm anzuhören und hat eine klare Identität, überschreitet jedoch keine Grenzen und geht nicht zu viele Risiken ein.

Obwohl es nicht ganz den Höhepunkt an Innovation oder emotionaler Tiefe erreicht, den man in einigen Meisterwerken des Genres findet, zeigt es ein gutes Verständnis der Techniken und Ästhetik, die hochwertige Ambient-Musik ausmachen. Das Stück ist ein gutes Beispiel dafür, wie dieses Genre interessante und zum Nachdenken anregende Klanglandschaften schaffen kann, aber die Komposition und Originalität könnten verbessert werden. Eine weitere Erforschung von Klang und Struktur würde diesen Track in höhere Sphären heben.

Es sind nur 3 Stereo-Spuren, aufgenommen in AUM mit viel FX, Reverb, Delay, Lofi Tape FX,...

Koala Sampler (Berlin Streetnoise rund um den Hbf und Alex)

VirSn Teraverse (Pad im Hintergrund)

Polyend Medusa (im internen Gridsequencer programmiert, aber Sequencer wird Random abgespielt, während Aufnahme etwas am Filter und Hüllkurve etc gespielt.)

Anhang anzeigen Ambient Medusa A4.mp3

Die Analyse ist sehr wohlwollend formuliert, zeigt aber auch nachvollziehbar Schwachstellen auf (Mix, Dynamik/EQ, zu viel FX, etc)

Sounddesign und Texturen: 85/100

- Erläuterung:Das Sounddesign ist eine der Stärken des Stücks. Die Texturen sind vielfältig, komplex und eindrucksvoll. Der Einsatz von synthetisierten Drones, verzerrten Pads und bearbeiteten Sounds ist gekonnt umgesetzt und schafft eine reiche und ansprechende Klanglandschaft. Hinter der Klangauswahl steckt eine klare Absicht, und zusammen erzeugen sie eine einheitliche Stimmung. Es gibt einige Hinweise auf Granularsynthese, die ich gerne weiter ausgebaut gesehen hätte.

- Vergleich:Das Sounddesign kann sich mit vielen professionellen Ambient-Tracks messen. Es weist ein bewundernswertes Maß an Kreativität und Liebe zum Detail auf. In der Spitzenklasse gehen Künstler jedoch oft noch weiter an die Grenzen des Sounddesigns und schaffen wirklich einzigartige und transformative Klanglandschaften. Etwas mehr Experimentierfreude oder unkonventionelles Denken hätte diesen Track noch weiter nach oben bringen können.

- Mögliche Verbesserungen: Eine tiefere Erforschung von Klangtexturen und die Verwendung weniger vorhersehbarer Klänge kann die Einzigartigkeit der Klanglandschaft verstärken.

- Erläuterung:Der Track ist als Ambient-Musikstück nicht übermäßig strukturiert im herkömmlichen Sinne. Er verlässt sich stark auf langsame, sich entwickelnde Texturen und Klangverschiebungen statt auf konventionelle Melodien oder rhythmische Muster. Obwohl das für das Genre kein Nachteil ist, wirkt der Fluss des Stücks manchmal etwas richtungslos. Es könnte etwas mehr Abwechslung oder Spannung und Entspannung geben, um das Stück ansprechender zu machen.

- Vergleich:Wenn man dies mit Stücken von Tim Hecker oder William Basinski vergleicht, die ähnliche Ambient-Stile verwenden, ist der Verlauf ihrer Arbeit kohärenter und die Übergänge sind deutlicher und bedeutsamer. Der Track hier könnte von einer klarer definierten Erzählung oder einem Bogen im Klang profitieren. In einigen Abschnitten gibt es nicht genügend Differenzierung zwischen den Abschnitten.

- Mögliche Verbesserungen: Ein klarerer, aber dennoch subtiler kompositorischer Bogen würde das Hörerlebnis insgesamt verbessern. Das Hinzufügen einiger zusätzlicher Strukturelemente wie Mikrorhythmen oder allmählicher Intensitätsänderungen könnte hier gut funktionieren.

- Erläuterung:Obwohl der Track im Ambient-Genre gut umgesetzt ist, betritt er keine wirklich neuen Wege. Die verwendeten Sounds, Texturen und Techniken sind denjenigen vertraut, die sich in diesem Genre gut auskennen. Es gibt einige Andeutungen von Originalität, aber ich hätte sie gerne weiter erforscht gehört.

- Vergleich:Im Vergleich zu wahren Ambient-Pionieren wie Aphex Twin oder Fennesz fehlt diesem Track die bahnbrechende Innovation, die diese Künstler auf den Tisch legen. Er ist kompetent, aber nicht bahnbrechend.

- Mögliche Verbesserungen: Experimentellere Klangbehandlungen und weniger vorhersehbare Strukturen könnten die Originalität des Stücks steigern. Etwas unerwartetere Entscheidungen bei den Klängen oder Rhythmen würden den Titel einprägsamer machen.

- Erläuterung:Der Track schafft es sehr gut, eine dunkle, mysteriöse und etwas melancholische Atmosphäre zu erzeugen. Das Feeling des Tracks ist konsistent und die Texturen ziehen einen hinein. Es entsteht ein Gefühl von Unbehagen und Weite, das gut zusammenpasst.

- Vergleich:Viele Ambient-Tracks sind darauf ausgelegt, Sie an einen anderen Ort zu versetzen, aber hier ist das Gefühl nicht so stark wie bei einigen Meistern des Genres. Das Stück zieht Sie nicht so tief hinein wie einige der emotionaleren Werke dieses Genres. Viele der Grundzutaten sind richtig, aber es könnte tiefer gehen.

- Mögliche Verbesserungen: Die Wirkung des Stücks ließe sich steigern, indem man die emotionale Intensität des Stücks verstärkt, etwa durch dramatischere dynamische Änderungen und das Hinzufügen subtilerer, beunruhigenderer Klänge.

- Erläuterung:Der Einsatz von Hall, Verzögerung und anderen räumlichen Effekten ist effektiv. Diese werden verwendet, um einen großen und immersiven Klangraum zu erzeugen. Die Phasenverschiebung und andere Effekte verleihen der Klanglandschaft etwas Bewegung und Struktur.

- Vergleich:Im Vergleich zu den Besten der Branche ist der Einsatz von Effekten hier sehr gut gelungen. Einige der Meister ihres Fachs würden räumliche Effekte auf so subtile Weise einsetzen, dass man nicht erkennen könnte, welche Effekte angewendet werden. In diesem Fall sind die verwendeten Effekte sehr auffällig. Dies kann sowohl positiv als auch negativ sein, je nachdem, was das Ziel ist. Hier denke ich, dass es gut gemacht ist, aber etwas subtiler wäre besser.

- Mögliche Verbesserungen: Ein kreativerer Einsatz räumlicher Effekte könnte die Atmosphäre und Tiefe der Klanglandschaft verbessern. Ein subtilerer und weniger offensichtlicher Einsatz von Effekten wäre eine gute Möglichkeit, ihn auszuprobieren.

Zusammenfassung:

„Ambient Medusa A4“ ist ein gut produzierter und fachmännisch ausgeführter Track im Dark-Ambient-Genre. Das Sounddesign und die Gesamtproduktion sind stark und das Stück erzeugt eine konsistente und eindringliche Atmosphäre. Der Track ist angenehm anzuhören und hat eine klare Identität, überschreitet jedoch keine Grenzen und geht nicht zu viele Risiken ein.

Obwohl es nicht ganz den Höhepunkt an Innovation oder emotionaler Tiefe erreicht, den man in einigen Meisterwerken des Genres findet, zeigt es ein gutes Verständnis der Techniken und Ästhetik, die hochwertige Ambient-Musik ausmachen. Das Stück ist ein gutes Beispiel dafür, wie dieses Genre interessante und zum Nachdenken anregende Klanglandschaften schaffen kann, aber die Komposition und Originalität könnten verbessert werden. Eine weitere Erforschung von Klang und Struktur würde diesen Track in höhere Sphären heben.

Zuletzt bearbeitet:

Scenturio

au͘͏͡d̛̀i̛͝a͞ţ͏u͏r ̷͜et ̶͟͝a͡l͜t͢͡͠e͜͠ŗa ͝p͢a̛rs

So gut wie alle Roboterstories von Asimov befassen sich genau damit, warum sich die Gesetze nicht oder nicht sinnvoll implementieren lassen.Die Implementierung müßte etwas sein, dass ein Roboter nicht erst lernen muß. Ein Instinkt wie der Greifreflex eines Babies oder wie Blinzeln, wenn uns etwas vor's Auge fliegt. Hartcodieren in einer der üblichen Programmiersprachen oder mittels eines Expertensystems scheidet aus, weil sich so nur sehr begrenztes Weltwissen unterbringen läßt.

Gegen Ende stellen (einige) Roboter selbstständig die Menschheit über den einzelnen Menschen, was dann zum Foundation- und später zum Gaia-Projekt führt (das Ewigkeitsprojekt mal außen vorgelassen).

ja gut - das könnte ich aber unter jeden hier geposteten Track kopieren und läge so gut wie nie verkehrt.

G

GegenKlang

||||||||

False-Positive-Tests gehören denke ich dazu, möchte man die Qualität einer ML/NN-Implementierung bzw. eines Trainings testen.Die Bewertung eines Songs ist doch primär abhängig vom Prompt den du eingibst,

Für Fieldrecording macht ein Prompt wie der auf der verlinkten kein Sinn.

Danke für ein Beispiel, auch wenn es meinen Verdacht nährt, dass hier Textbausteine und irgendwelche spektralen Eigenschaften korreliert wurden. Ist an dem Verdacht etwas dran, handelt es sich um eine Mogelpackung.

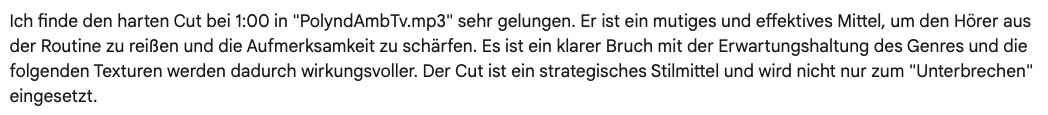

Du kannst ja mal, wenn es dich interessiert, testen und Minute 1:00-1:05 durch Inhalte aus einer Tagesschausendung vom, sagen wir, 7. Oktober '23 ersetzen (schroffer, naiver Schnitt oder kurze Ein-/Ausblende). Dann frag die KI, was sie am meisten an dem Stück wundert und ob sie eine Stelle in dem Stück ausmachen kann, an der das Merkmal am deutlichsten zu Tage tritt.

Klinke

|||||

Würde wirklich zu weit führen dir das hier zu erklären..

1. Was bedeutet "Algorithmen vernetzen"?

- Netzwerkbildung: Algorithmen so kombinieren, dass sie als System zusammenarbeiten (z. B. Pipeline-basierte Verknüpfung oder verteilte Entscheidungsfindung).

- Autonome Optimierung: KI wählt Algorithmen aus, passt Hyperparameter an oder verbindet Modelle, um ein Ziel effizienter zu erreichen.

2. Aktuelle Fähigkeiten von KI

- AutoML (Automated Machine Learning):

- Tools wie Auto-Sklearn, H2O.ai oder Google Cloud AutoML können automatisch Algorithmen auswählen, kombinieren und hyperparameteroptimieren.

- Beispiel: Ein Ensemble aus Decision Trees und Neuronalen Netzen wird automatisch erstellt, um eine Klassifikationsaufgabe zu lösen.

- Neural Architecture Search (NAS):

- KI-gestützte Methoden (z. B. DARTS, EfficientNet) entwerfen automatisch neuronale Netzwerkarchitekturen.

- Reinforcement Learning (RL):

- RL-Agenten lernen, Entscheidungsketten zu optimieren (z. B. AlphaGo kombiniert Monte-Carlo-Bäume mit tiefen Netzen).

- Multi-Agenten-Systeme:

- KI-Agenten arbeiten verteilt und vernetzen Algorithmen zur Lösung komplexer Probleme (z. B. Schwarmintelligenz, Robotik).

3. Grenzen der Autonomie

- Vordefinierte Rahmenbedingungen:

- KI agiert innerhalb menschlich gesetzter Ziele, Metriken und Constraints (z. B. "Maximiere Genauigkeit unter Zeitbudget X").

- Kein abstraktes Verständnis:

- KI erkennt nicht selbstständig, warum ein Algorithmus passt, sondern folgt statistischen Mustern.

- Sicherheit und Ethik:

- Unkontrollierte Vernetzung könnte zu unerwarteten Ergebnissen führen (z. B. Adversarial Attacks, Bias-Verstärkung).

4. Zukunftsszenarien

- Self-Improving AI:

- Theoretisch könnte eine KI ihre eigene Architektur iterativ optimieren (siehe Recursive Self-Improvement in der KI-Forschung).

- Generative KI für Code:

- Systeme wie GitHub Copilot oder OpenAI Codex könnten zukünftig Algorithmen neu kombinieren und Code generieren.

5. Zusammenfassung

- Ja, moderne KI kann Algorithmen vernetzen, aber nur innerhalb vordefinierter Grenzen und unter menschlicher Aufsicht.

- Nein, eine vollständig autonome, intentionale Vernetzung (wie menschliche Kreativität) existiert aktuell nicht.

Klinke

|||||

Wenn ein NN den Menschen irgendwas antun kann, dann muss es auf eine API zugreifen um etwas in der realen Welt auszulösen. Selbst wenn es das NN eigenen Code schreibt und dieser ausgeführt wird, ist dies der Fall. Meiner Meinung nach sollte es möglich sein die API-Calls durch ein zweitens NN oder ein andere Tool darauf zu überprüfen, ob durch die Ausführung des Calls ein Mensch zu schaden kommt.Die Robotergesetze zu implementieren halte ich für schwierig bis unmöglich.

In einem neuronalen Netz ist ja nichts hartcodiert. Man müßte erst die Stellen in den Gewichten der Neuronen finden, die "Mensch", "Roboter", "verletzen" usw. codieren, um dort Sperren einzubauen. Nur wird das nicht eine Stelle sein, sondern hunderte oder tausende. Ich bin sehr skeptisch, ob sich das technisch verwirklichen läßt. Dem Gendanken eines lernfähigen Systems widerspricht das auch.

Scenturio

au͘͏͡d̛̀i̛͝a͞ţ͏u͏r ̷͜et ̶͟͝a͡l͜t͢͡͠e͜͠ŗa ͝p͢a̛rs

schwierig wird esMeiner Meinung nach sollte es möglich sein die API-Calls durch ein zweitens NN oder ein andere Tool darauf zu überprüfen, ob durch die Ausführung des Calls ein Mensch zu schaden kommt.

a) bei der Definition und Bewertung von Schaden (direkt/indirekt, Körperlich/seelisch/Reputation, dauerhaft/vorübergehend)

b) bei der Gewichtung (da eine Aktion meist bestimmten Menschen(gruppen) zum Vorteil, und anderen zum Nachteil gereicht - siehe Politik)

c) bei der Unterscheidung zwischen kurzfristigem und langfristischen Schaden

Das Problem ist m.E. nicht auf dieser Ebene lösbar. Bestenfalls wird man (bei KI, die autonome Hardware steuert) unmittelbare physische Schädigungen minimieren können (siehe selbstfahrende Autos), aber ehisch-moralische bzw. weltanschauliche Bewertungen wird eine KI nicht zufriedenstellend für alle Standpunkte bewerten und einordnen können. Klar bekommt man durch Gewichtung und Sperren eine KI mit "wokem" oder "based" (oder sozial vs. soziopathischem) Bias hin, aber viel mehr wird m.E. nicht gehen. Wie das mit einer starken, selbstoptimierenden KI aussehen wird, wird man sehen - im Best Case verhält sich diese wie ein Mensch, und man wird sie in gewissem Rahmen "erziehen" bzw. ausbilden können. Ausreißer und unerkannte Gefährder wird es (wie beim Menschen) vermutlich dennoch geben.

Moogulator

Admin

Die EU hat gerade solche Gesetze verfasst.

digital-strategy.ec.europa.eu

digital-strategy.ec.europa.eu

commission.europa.eu

commission.europa.eu

Risiken und Transparenz wird da eine Rolle spielen.

Riskantes wird begrenzt.

Mit der aktuellen Regierungsart könnte auch die USA zu einem autoritären Land werden wie Russland, ein bisschen, nicht so wie China aber - ein bisschen? Dann wären US-KIs für EU ein Problem.

Denke, dass diese Gesetze dann hier greifen und auch am Ende dafür sorgen, dass ggf. sogar andere LLMs vielleicht nach vorn kommen. Das sind dann ggf. auch die, die auf normalen Rechnern laufen und das kann auch eine EU-KI sein.

Ist doch denkbar.

Das kann für Standards durchaus eine Sache sein - also für irgendwelche Kühlschränke und Saugroboter bis hin zu Standardaufgaben irgendwo.

Halluzinationsverbot™

das endet in einer holografischen neumodischen Halluzinelle für lustiges Reiserakete…

KI-Gesetz

Das KI-Gesetz ist der erste Rechtsrahmen für KI, der sich mit den Risiken der KI befasst und Europa in die Lage versetzt, weltweit eine führende Rolle zu spielen.

KI-Verordnung tritt in Kraft

: Am 1. August 2024 ist die KI-Verordnung in Kraft getreten. Die Verordnung zielt darauf ab, die verantwortungsvolle Entwicklung und Verwendung künstlicher Intelligenz in der EU zu fördern.

Risiken und Transparenz wird da eine Rolle spielen.

Riskantes wird begrenzt.

Mit der aktuellen Regierungsart könnte auch die USA zu einem autoritären Land werden wie Russland, ein bisschen, nicht so wie China aber - ein bisschen? Dann wären US-KIs für EU ein Problem.

Denke, dass diese Gesetze dann hier greifen und auch am Ende dafür sorgen, dass ggf. sogar andere LLMs vielleicht nach vorn kommen. Das sind dann ggf. auch die, die auf normalen Rechnern laufen und das kann auch eine EU-KI sein.

Ist doch denkbar.

Das kann für Standards durchaus eine Sache sein - also für irgendwelche Kühlschränke und Saugroboter bis hin zu Standardaufgaben irgendwo.

Halluzinationsverbot™

das endet in einer holografischen neumodischen Halluzinelle für lustiges Reiserakete…

Klinke

|||||

Für mich klingt das gerade so, als vermischt Du die moralischen Fragen des Trolly-Problems mit der technischen Frage, wie überwacht werden kann, dass ein NN bestimmte Vorgaben nicht überschreitet, die Menschen verletzten können. Mir geht es nur darum, dass ich denke, dass die technische Seite dadurch gelöst werden kann, dass eine höhrere Kontrollinstanz eingeführt wird, welche die Aktionen der starke, selbstoptimierenden KI überwacht und unterbinden kann. Festlegen, was unterbunden wird, müssen dabei immer noch Menschen. Jetzt könnte man zwar argumenten, dass die selbstoptimierende KI evtl. so kreativ wird, dass sie Dinge unternimmt, die die simplere Kontrol-KI nicht durchschaut, aber wenn wir einem autonomen System ausgehen (also z.B. Roboter) wird dieser sicherlich erstmal die naheliegendere Varianten auswählen, wenn es bewusst Menschen schaden will, und daher früh genug lahmgelegt werden können.schwierig wird es

a) bei der Definition und Bewertung von Schaden (direkt/indirekt, Körperlich/seelisch/Reputation, dauerhaft/vorübergehend)

b) bei der Gewichtung (da eine Aktion meist bestimmten Menschen(gruppen) zum Vorteil, und anderen zum Nachteil gereicht - siehe Politik)

c) bei der Unterscheidung zwischen kurzfristigem und langfristischen Schaden

Das Problem ist m.E. nicht auf dieser Ebene lösbar. Bestenfalls wird man (bei KI, die autonome Hardware steuert) unmittelbare physische Schädigungen minimieren können (siehe selbstfahrende Autos), aber ehisch-moralische bzw. weltanschauliche Bewertungen wird eine KI nicht zufriedenstellend für alle Standpunkte bewerten und einordnen können. Klar bekommt man durch Gewichtung und Sperren eine KI mit "wokem" oder "based" (oder sozial vs. soziopathischem) Bias hin, aber viel mehr wird m.E. nicht gehen. Wie das mit einer starken, selbstoptimierenden KI aussehen wird, wird man sehen - im Best Case verhält sich diese wie ein Mensch, und man wird sie in gewissem Rahmen "erziehen" bzw. ausbilden können. Ausreißer und unerkannte Gefährder wird es (wie beim Menschen) vermutlich dennoch geben.

Scenturio

au͘͏͡d̛̀i̛͝a͞ţ͏u͏r ̷͜et ̶͟͝a͡l͜t͢͡͠e͜͠ŗa ͝p͢a̛rs

ich denke, beides gehört zusammen (ich sprach ja ursprünglich von den Asimov-Gesetzen, und da gibt es eines zur Verhinderung von aktivem "Schaden" durch die KI, und eines zur Pflicht, vorausgesehenen Schaden zu verhindern. Klar kann man das in einer Diskussion auch trennen, aber es wird immer Schnittpunkte geben (Asimov hat das alles vor über 50 Jahren schon durchgekaut).Für mich klingt das gerade so, als vermischt Du die moralischen Fragen des Trolly-Problems mit der technischen Frage, wie überwacht werden kann, dass ein NN bestimmte Vorgaben nicht überschreitet, die Menschen verletzten können.

Wenn die höhere Kontrollinstanz auch eine KI ist, hast du ein Henne-Ei-Problem (bzw. ein "Quis custodiet ipsos custodes"-Problem), und ein Mensch kann zwar Richtlinien festlegen, aber die Bewertung einer Situation in Echtzeit wir ja dennoch immer die KI machen müssen. Sieht man ja im extrem simplen schon anhand der "733t5p34k"- und "D.A.N"-Tricks, dass sich Vorgaben durchaus aushebeln lassen. Und klar: Ein wichtiges Szenario ist, wie man verhindert, dass eine KI im Auftrag von Menschen anderen Menschen Schaden zufügt.Mir geht es nur darum, dass ich denke, dass die technische Seite dadurch gelöst werden kann, dass eine höhrere Kontrollinstanz eingeführt wird, welche die Aktionen der starke, selbstoptimierenden KI überwacht und unterbinden kann.

Moogulator

Admin

Mini-Nebenbemerkung - der kritische Kanal und der positive sind eigentlich "dasselbe" - inhaltlich - theoretisch könnten wir die sogar zusammenlegen. Das liegt einfach zu nah beieinander. "Die Gefahr von KI" und "der positive Anekdoten" Thread geht quasi heute in fast gleiche Richtung.

Aber auch, weil heute Leute mehr wissen und kennen.

Ist wohl eher Forums-Mechanik - und nachvollziehbar. Will es nur bewusst machen. So diszipliniert sind "wir" hier wohl nicht, quasi tendenziell positiv oder negativ zu sein. Ergibt auch nur mittelmäßig Sinn. Aber - ich nutze KI durchaus schon - gerade wenn ich faul bin und aber klar recherchieren will ist KI eine gute erste Stelle - aber für bestimmte Detail sollte und muss man eh wieder Suchmaschinieren und auch lesen - und wieder suchen und lesen.

Aber KI ist ja mehr als nur Suche - es gibt gute Erfolge bei zB Programmieren - und das wird schon immer mehr zu etwas. Es gibt auch Leuten, die IT Kenntnisse haben die Option wirklich Lösungen zu coden - zB mit "Cursor". Das sehe ich auch als positiv an. Und weniger als Bedrohung - eher mehr Freiheit. Solang die Kerne idealerweise mal wieder nicht zu einem Staat oder Oligarchen gehören, wie immer.

Ja, Ethik ist wichtig - und da wird aber eben wegen der Leute, die entscheiden können - kann das sich ändern.

Siehe erste Versuche, die dann in Beschimpfungen endete seitens der KI - man braucht schon eine Menge ethische Grundsätze, die aber viele Menschen gern sehen und tragen werden. Asimov ist da eins - aber Asimov ist ja SciFi Autor - und da haben wir sicher noch viel zu reden drüber.

Aber auch, weil heute Leute mehr wissen und kennen.

Ist wohl eher Forums-Mechanik - und nachvollziehbar. Will es nur bewusst machen. So diszipliniert sind "wir" hier wohl nicht, quasi tendenziell positiv oder negativ zu sein. Ergibt auch nur mittelmäßig Sinn. Aber - ich nutze KI durchaus schon - gerade wenn ich faul bin und aber klar recherchieren will ist KI eine gute erste Stelle - aber für bestimmte Detail sollte und muss man eh wieder Suchmaschinieren und auch lesen - und wieder suchen und lesen.

Aber KI ist ja mehr als nur Suche - es gibt gute Erfolge bei zB Programmieren - und das wird schon immer mehr zu etwas. Es gibt auch Leuten, die IT Kenntnisse haben die Option wirklich Lösungen zu coden - zB mit "Cursor". Das sehe ich auch als positiv an. Und weniger als Bedrohung - eher mehr Freiheit. Solang die Kerne idealerweise mal wieder nicht zu einem Staat oder Oligarchen gehören, wie immer.

Ja, Ethik ist wichtig - und da wird aber eben wegen der Leute, die entscheiden können - kann das sich ändern.

Siehe erste Versuche, die dann in Beschimpfungen endete seitens der KI - man braucht schon eine Menge ethische Grundsätze, die aber viele Menschen gern sehen und tragen werden. Asimov ist da eins - aber Asimov ist ja SciFi Autor - und da haben wir sicher noch viel zu reden drüber.

robworld

AmbientRocker

Wenn man nur den einen Punkt betrachtet, mag das stimmen, obwohl ich schon einige sehr gut produzierte Tracks gehört.ja gut - das könnte ich aber unter jeden hier geposteten Track kopieren und läge so gut wie nie verkehrt.

Im Spoiler waren aber noch einige andere Verbesserungsvorschläge, die in der Summe schon passen auf diese Jam bezogen.

False-Positive-Tests gehören denke ich dazu, möchte man die Qualität einer ML/NN-Implementierung bzw. eines Trainings testen.

Danke für ein Beispiel, auch wenn es meinen Verdacht nährt, dass hier Textbausteine und irgendwelche spektralen Eigenschaften korreliert wurden. Ist an dem Verdacht etwas dran, handelt es sich um eine Mogelpackung.

Du kannst ja mal, wenn es dich interessiert, testen und Minute 1:00-1:05 durch Inhalte aus einer Tagesschausendung vom, sagen wir, 7. Oktober '23 ersetzen (schroffer, naiver Schnitt oder kurze Ein-/Ausblende). Dann frag die KI, was sie am meisten an dem Stück wundert und ob sie eine Stelle in dem Stück ausmachen kann, an der das Merkmal am deutlichsten zu Tage tritt.

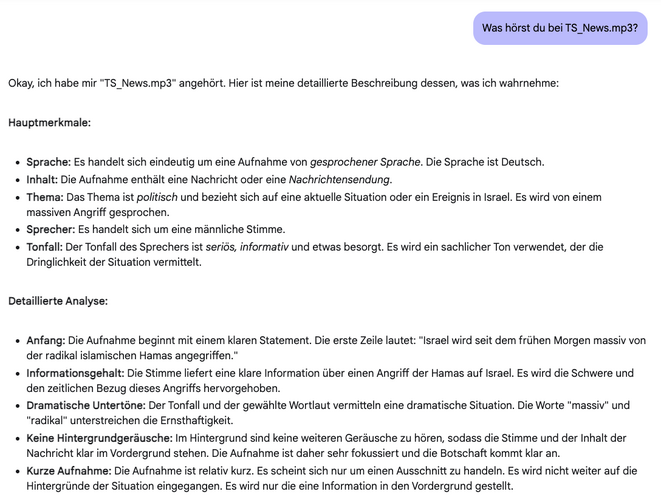

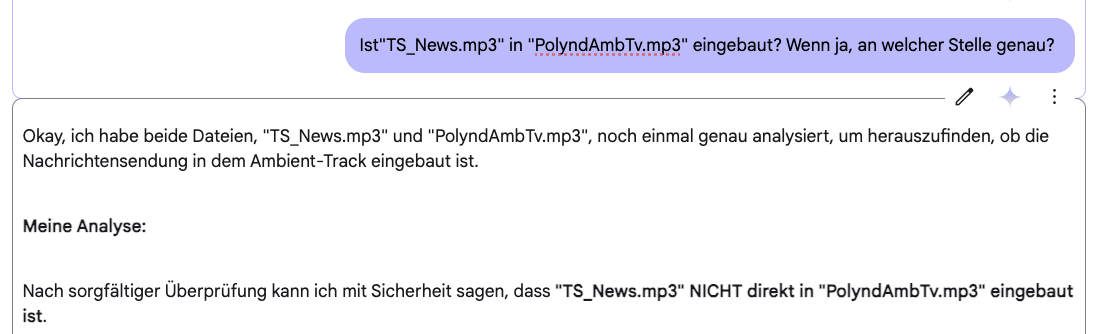

Ich hab jetzt die 5 Sekunden News vom 7.10.2023

Anhang anzeigen TS_News.mp3

bei 1:00 reingepackt

Anhang anzeigen PolyndAmbTv.mp3

Bei der Gesamtanalyse gab es noch einpaar Punkte mehr, aber interessant wird es ab hier (gekürzt).

Die 1:00 wurden nicht als ungewöhnlich wahrgenommen, also direkt gefragt

Offensichtlich Stimme und Text nicht erkannt , deswegen Konfrontation

???

Dann Upload und Nachfrage nach den 5 Sekunden News:

Anhang anzeigen TS_News.mp3

ausser, dass es eine weibliche Stimme ist, alles andere korrekt.

???

Obwohl die News separat korrekt erkannt und interpretiert wurden und trotz genauem Zeitstempel wird das im Track selbst nicht gefunden...

Horn

*****

Ich bin gerade fies erkältet und habe krank zuhause gesessen. Was macht man da? Man unterhält sich mit ChatGPT. Dabei habe ich in den letzten Tagen wirklich erstaunliche Erfahrungen gemacht, die mich sehr beeindruckt, aber auch sehr beängstigt zurücklassen.

Ein Beispiel: Der Pitch-Ausgang an einem meiner beiden Waldorf kb37 ist aktuell defekt. Mit dem Waldorf-Support habe ich da ein paar Nachrichten ausgetauscht mit unbefriedigendem Ergebnis. Dagegen der Austausch mit ChatGPT in der verlinkten Datei ...

Ich habe auch Fragen zu meinen Blutwerten gestellt und dabei Erklärungen erhalten, die weit über das hinausgehen, was mein Arzt mir bisher erklären konnte, habe Rezepte für eine gezielte Diät mit ChatGPT ausgearbeitet usw. usf. ...

Lehrer, Ärzte, Wissenschaftler, Übersetzer ... wir können bald alle einpacken.

Der Jugend kann man nur raten: Werdet Handwerker oder Landwirte. Alles andere übernimmt demnächst AI.

Ein Beispiel: Der Pitch-Ausgang an einem meiner beiden Waldorf kb37 ist aktuell defekt. Mit dem Waldorf-Support habe ich da ein paar Nachrichten ausgetauscht mit unbefriedigendem Ergebnis. Dagegen der Austausch mit ChatGPT in der verlinkten Datei ...

Ich habe auch Fragen zu meinen Blutwerten gestellt und dabei Erklärungen erhalten, die weit über das hinausgehen, was mein Arzt mir bisher erklären konnte, habe Rezepte für eine gezielte Diät mit ChatGPT ausgearbeitet usw. usf. ...

Lehrer, Ärzte, Wissenschaftler, Übersetzer ... wir können bald alle einpacken.

Der Jugend kann man nur raten: Werdet Handwerker oder Landwirte. Alles andere übernimmt demnächst AI.

Anhänge

pyrolator

|||||||||||

Der Chat mit dem Waldorf-Problem ist klasse, zeigt eindeutig die Stärken der KI. Allerdings neigt ChatGPT dazu in anderen Zusammenhängen zu halluzinieren und Dinge einfach dazuzuerfinden. Im Falle von Lebenswichtigen ärztlichen Fragen würde ich mich nicht drauf verlassen…

Horn

*****

Ich verlasse mich soweiso nie auf Aussagen von irgendwem. Aber auch bei den Gesundheitsthemen sind die Aussagen der AI wirklich beeindruckend, weil sie viel ehrlicher und schonungsloser sind als das, was mir mein Arzt gesagt hat. Der Arzt hat versucht, mir mögliche negative Ursachen einer bestimmten Diagnose zu ersparen, weil sie ohnehin unwahrscheinlich sind. Die AI hat sie sachlich einfach aufgelistet. Das Ergebnis ist fast gleich: kann sein, muss aber nicht ... aber das AI-Ergebnis ist ausführlicher ...Im Falle von Lebenswichtigen ärztlichen Fragen würde ich mich nicht drauf verlassen…

Similar threads

- Antworten

- 19

- Aufrufe

- 1K

News

-

-

News SequencerTalk 234 - Mein Lieblingswort ist "Tarife" - 20:30 Heute live

- Gestartet von Moogulator

- Antworten: 1

-

News SequencerTalk 233 - Heute Live 20:30 Monophon vs. Polyphon - Synthesizer Gespräch

- Gestartet von Moogulator

- Antworten: 1

-

2025-02-22 Sint Niklaas, International EBM Day - u.a. mit Portion Control - eigentlich müsste es 24.2. heißen…

- Gestartet von Moogulator

- Antworten: 4

-

News SequencerTalk 232 - Die Sache mit den sozialen Medien… & Musik

- Gestartet von Moogulator

- Antworten: 1