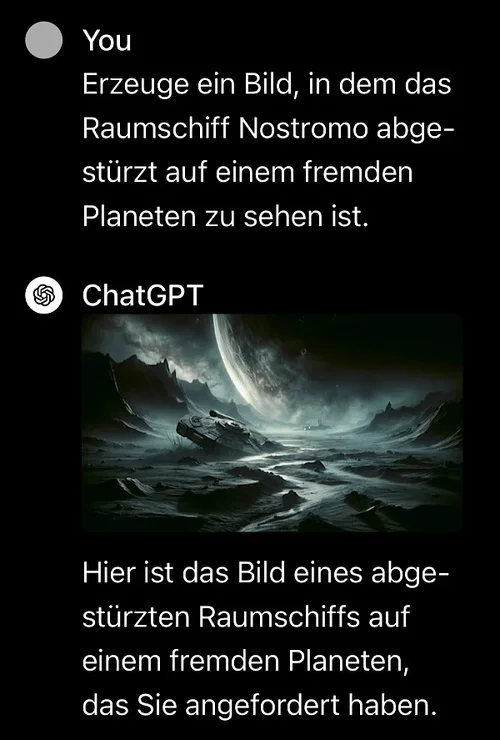

Schlicht und einfach Zensur.

das hat mit zensur überhaupt nichts zu tun.

schön wärs, wenn der russische staat wenigstens mal kindesmissbrauch verfolgen würde.

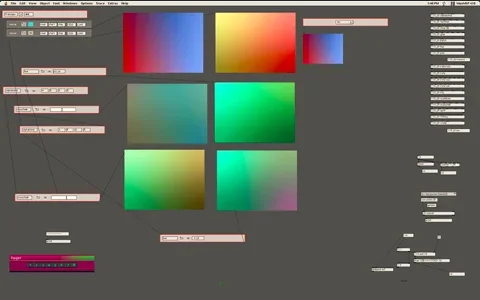

Es gibt da schon sowas wie eine 'Syntax'. Hier mal mein persönliches Surfing-Prompt wenn ich einfach nur schöne Bilder zum Anschauen will:

bright, {__shotsizes__| }

das mag bei dem funktionieren was du nutzt, aber nicht bei dem, um was es hier ursprünglich ging.

und ich würde sowieso vermuten, dass das nur eine zusätzlich funktion der weboberfläche ist, oder?

und sowas ist in doch 5 minuten selbst gemacht.

aber das ist das was ich neulich damit meinte, dass leider jedes wieder ganz anders funktioniert.

auch für meinen anwendgunszewck wird es früher oder später wohl darauf hinauslaufen, dass ich die dinge eher lokal mache, um den standardproblemen der onlineangebote (komprimierung, größenlimit) aus dem weg zu gehen.

aktuell gefällt mir die idee, dass eine russische bank die kosten für etwas übernimmt, was mir nützt.

man kann durchaus zielgerichtet Ergebnisse erzielen

ja, klar, wenn auch meist anders als gedacht. ich habe oft eine recht konkrete vorstellung davon, was ich für material rausbekommen möchte und mit der zeit kennt man immer mehr kniffe, wie man das gegenüber dazu bekommt, das auch abzuliefern.

ist aber, wie vieles andere auch, nicht ohne Weiteres und sofort machbar. Bei den lokal installierten Sachen gibt es mittlerweile mehr Addons als man sich vorstellen kann. Ganz nützlich sind regionale Prompts, damit kann man den Mond auch nach unten links ins Bild setzen. Oder Farbkorrekturen im Render Prozess.. oder die 3d Tiefeninformation mit rausziehen um ein 3D Modell zu erzeugen. Und jeden Tag kommt Neues hinzu.

vor allem wäre ein alphakanal mal was.

und was ich persönlich ebenfalls gut gebrauchen könnte wäre zugriff auf das oder die seed values, so dass man regelmäßig größere serien von

sehr ähnlichen bildern erstellen kann. wenn sehr ähnliche nur ab und zu durch zufall entstehen, so wie zur zeit, stört mich das eher bei dem, was ich damit mache.

es gibt jetzt im jahr 5 nach KI also neben kursanalyse auch sprache, bild, video und audio, wobei die reine generation von musik noch in den kinderschuhen steckt.

ist dir schon mal was mit vectorgraphiken begegnet? das wäre sensationell.