die Programmiersprache sollte bei so gut wie jeder MIDI-Anwendung ziemlich egal sein

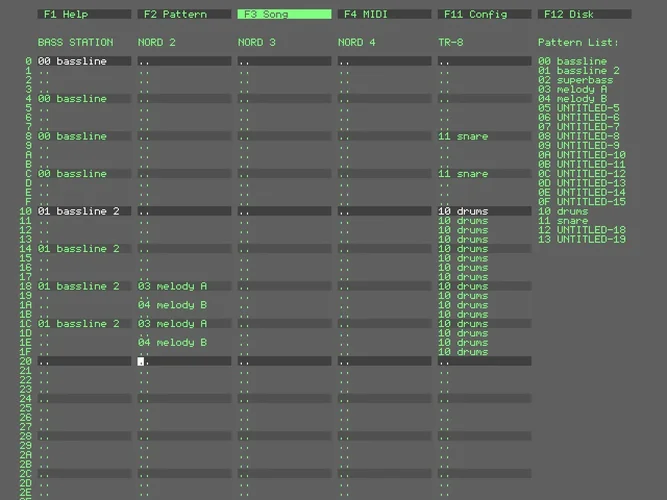

Also, mein Sequencer-Programm verwendet einen Main-Loop, in dem auf einkommende Noten von seq24 geprüft wird, auf Events auf dem PC-Keyboard (mit den Modulen "termios", "select" und "tty") und auf dem Midi-Keyboard, dann müssen die Berechnungen durchgeführt werden, und zur passenden Zeit müssen Midi-Events an alsa-jack gegeben werden, wobei auf Note-On und Note-Off geprüft werden muß. Während auf dem PC gleichzeitig noch zig andere Prozesse ablaufen.

Da wäre es schon gut, wenn dieser Loop wirklich schnell und damit häufiger ablaufen könnte.

Sonst kann es halt passieren, daß es zu leichten Verzögerungen bei den Noten kommt.

Diese Verzögerungen gibt es auch, aber für meine Hobby-Zwecke ist es ausreichend.

Zur Not kann man die Midi-Events, die das Skript ausgibt, auch aufzeichnen und ggf. nachquantisieren.

Aber es wäre halt schön, wenn es auch in Echtzeit verläßlich ohne Verzögerungen ablaufen würde. Na, man kann nicht alles haben.

Ich mein', man würde ja auch nicht aufwendige, moderne Spiele in einer Skriptsprache schreiben. Die bequemen Datentypen mit automatischer Speicherverwaltung kosten halt Zeit während der Programmausführung. Und wenn sich der Code in irgendwelchen Modulen verfängt, die man eingebunden hat, kostet das auch Zeit. Is' nunmal so.

Trotzdem: Wenn man C64-Basic oder in meinem Fall ZX Spectrum-Basic gewohnt ist, ist Python auf einem modernen Rechner im Vergleich sauschnell. Damit kann man schon eine Menge machen.