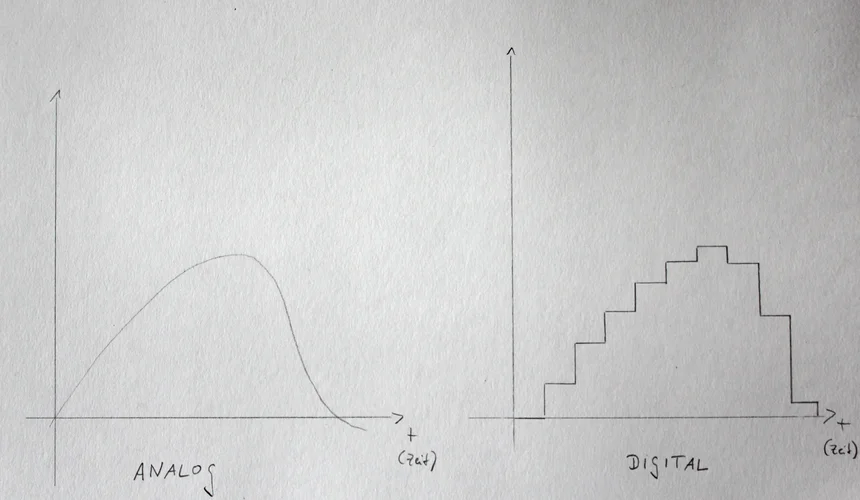

Ich hab da mal was gezeichnet ...

Links das analoge Audio. Das kann im Grunde ne Schwingung in der Luft sein oder das Signal in einem analogen Synthesizer. Einmal ist das Medium die Luft, einmal elektrische Ladungen.

Kern von analogen Schaltungen ist, dass sie einen kontinuierlichen Verlauf haben. Sprich, für jeden Zeitpunkt gibt es einen ganz individuellen Wert, der im Grunde nie identisch mit dem Vorherigen ist. Auch gibt es eigentlich keinen Vorherigen, da man in den Verlauf "unendlich" fein reinzoomen kann.

Und alle klassischen Audiosignale sind erstmal analog. Ob das die Aufnahme mit nem Mikro ist, die Schwingungen einer E-Gitarre usw.

Um Audiosignale digital verarbeiten zu können, müssen sie zwangsläufig digitalisiert werden. Warum man das macht, kann viele Gründe haben. Vor allem ist inzwischen die Speicherung und auch Verarbeitung (finanziell) deutlich günstiger.

Die Digitalisierung sieht man in der Skizze. Dabei wird aus dem Linken, das rechte Signal. Digitale Audiosignale sind dann immer nur eine Annäherung an das analoge Ursprungssignal, nie identisch.

Wie fein diese Annäherung ist, beschreiben die Digitalisierungsparamter der Abtastfrequenz (zB 44.1kHz), das ist die Auflösung in zeitlicher (x-Richtung) und die Bitrate (zB 16bit) in y-Richtung.

Was nun der große Unterschied zwischen analogen und digitalen Synthesizern ist, ist dass einmal die Verarbeitung (Filterung etc.) mit analogen Bauelementen, wie Transistoren, Kondensatoren und Widerständen passiert. Das andere Mal mit digitalen, sprich logischen Bauelementen (="Mikrochips"). Und auch, wenn Mikrochips aus vielen Kondensatoren bestehen, ist die Verarbeitung eine andere.

Und will man die digitalen Audiosignale schlussendlich abspielen, werden sie wieder in Analoge verwandelt. Und dann über einen Lautsprecher ausgegeben.

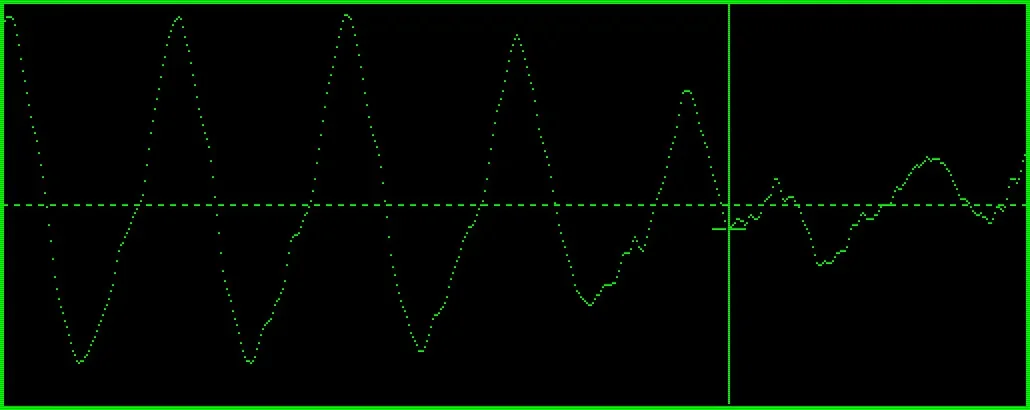

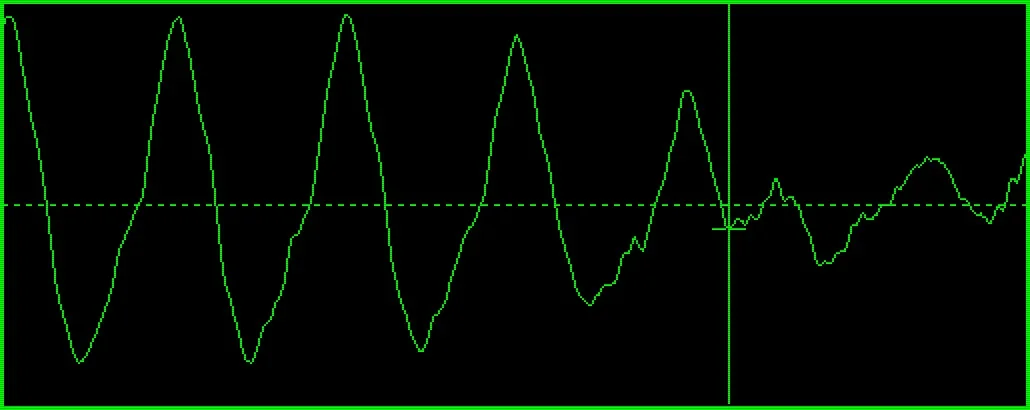

Anhang anzeigen 159625